EDITO

"J'AI UN FACTEUR D'IMPACT PLUS ÉLEVÉ QU'EINSTEIN !"

Décrié par tous mais par tous utilisé, le facteur d'impact est sans doute l'indicateur bibliométrique le plus connu et le plus employé. Il suscite pourtant de violents débats qui traversent de part en part le monde scientifique. Créé dans les années 1950, le facteur d'impact avait initialement été pensé pour aiguiller les bibliothécaires dans leurs achats de revues. Il représente le taux de citation des articles d'une revue scientifique dans l'ensemble des articles du même champ de recherche. Pourtant en soixante ans, même si son calcul n'a guère changé, le facteur d'impact a pris une importance toute autre. Il est devenu une référence internationale pour l'évaluation des scientifiques, c'est-à-dire la sélection des projets et l'attribution des fonds. Comment donc est-on passé d'un simple indicateur de lectorat à un outil mondialement utilisé pouvant s'avérer décisif dans la carrière d'un scientifique ?

Le drame se noue.

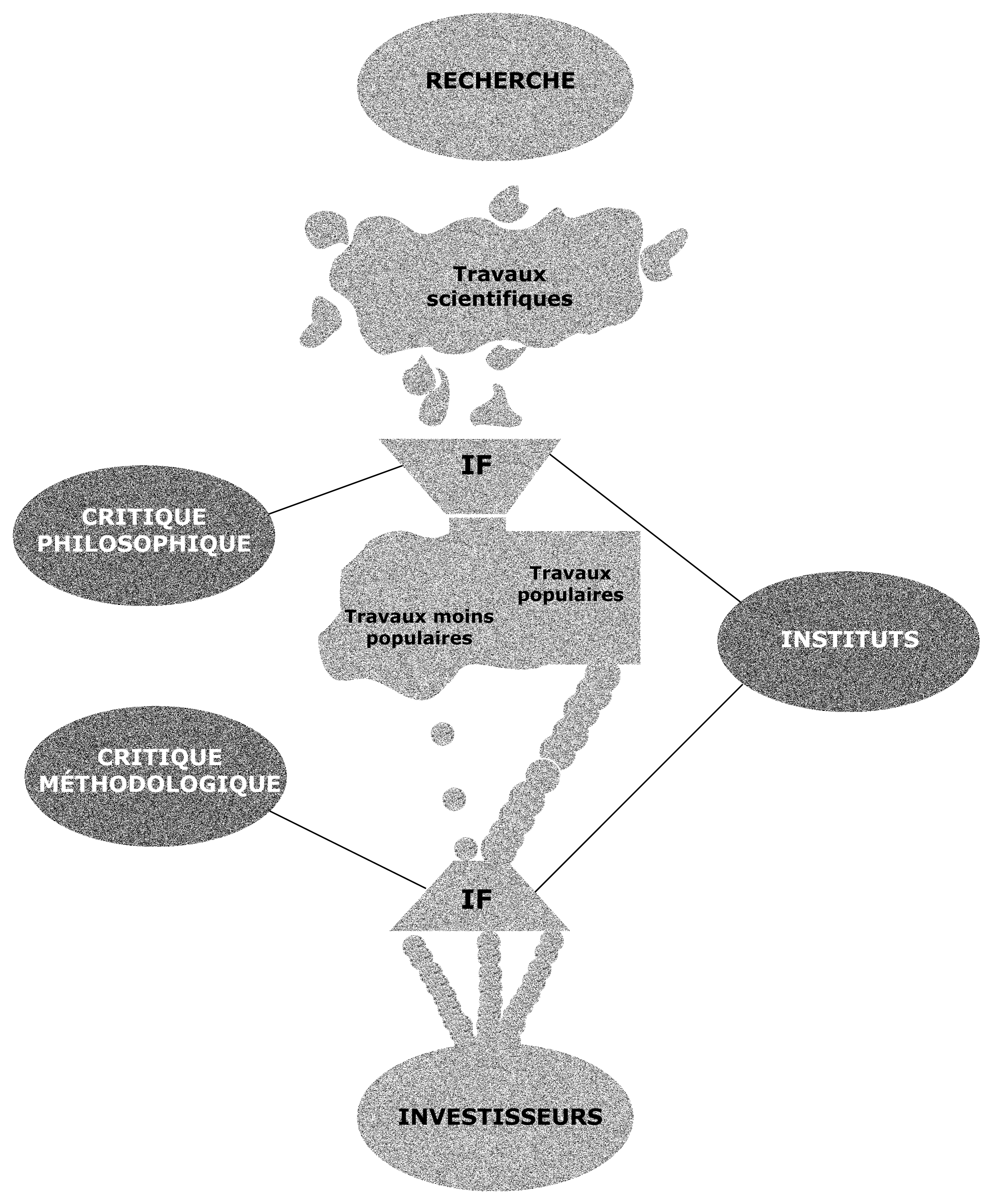

Un premier constat s'impose : c'en est fini de l'évaluation bienveillante par les pairs comme pratiquée aux débuts de la science moderne, à l'âge d'or de la recherche scientifique. Cloisonnée dans le laboratoire, la recherche était alors le fait d'une communauté solidaire régulée par l'interconnaissance et la reconnaissance mutuelle. Un monde scientifique indépendant du reste de la société, comme suspendu par un fil le reliant directement à la vérité, voilà résumée la vision d'un passé romanesque partagée par tous les chercheurs que nous avons pu interviewer. Aujourd'hui, la situation est toute autre : l'investisseur rationnel, qui a remplacé le mécène, cherche avant tout la rentabilité. Ce contexte modifie profondément la forme que prend la compétition entre scientifiques. L'enjeu n'est plus seulement d'être crédible auprès de ses confrères. Il est surtout devenu impératif d'attirer les investisseurs par la productivité, ce qui implique l'abandon de la solidarité au profit de la concurrence.

L'investisseur est un agent économique en situation d'information imparfaite. Il doit se contenter d'observations indirectes pour tenter d'objectiver ses décisions. L'ouverture de la recherche aux investisseurs a ainsi pour corollaire le développement de l'évaluation de la recherche. C'est sur cette vague que surfe le facteur d'impact : facilement calculable, facilement généralisable, l'indicateur n'a eu aucun mal à s'imposer comme référent hégémonique parmi les indicateurs bibliométriques.

Le drame se joue.

Ainsi décrit, l'avènement du facteur d'impact semble participer d'une nécessité historique contre laquelle il serait vain de lutter. Pourtant, la tendance actuelle semble être, qu'on se situe du côté des chercheurs, des agences gouvernementales (OST, AERES, ANR, …) ou des ONG, à la critique de l'indicateur-roi. Comment donc expliquer la popularité d'un indicateur qui fait plutôt consensus contre lui ?

L'histoire de la généralisation du facteur d'impact est avant tout celle d'un détournement. Ce dernier est selon nous le fait d'un acteur pivot : les éditeurs de revues scientifiques. Ce sont eux qui ont investi le facteur d'impact et l'ont diffusé massivement puisqu'il représentait un moyen efficace de structurer leur marché. Ce glissement est au cœur de la controverse que nous avons pour projet de décrire. La tension n'est pas fondamentalement entre ceux qui soutiennent et ceux qui condamnent le facteur d'impact. Elle réside davantage dans les écarts et les incompréhensions qui séparent les critiques de chaque acteur à l'égard de l'évolution du rôle de l'indicateur.

Ce site raconte l'histoire de Frankenstein. La créature des maisons d'éditions semble leur avoir échappé. La question est de savoir s'il convient de l'abattre ou de la domestiquer.

LA GENÈSE DU FACTEUR D'IMPACT

Eugène Garfield est le créateur du facteur d'impact. Américain né en 1925, il s'est spécialisé dans les sciences de l'information et des bibliothèques, après avoir étudié la chimie et la linguistique. Il est l'un des fondateurs de la bibliométrie et de la scientométrie, les disciplines scientifiques ayant pour objet la mesure et l'analyse de la science. En 1958 il a fondé l'Institute for Scientific Information (ISI), depuis racheté par Thompson Reuters (1992), qui entretient plusieurs bases de données de revues scientifiques accessibles depuis le service Web of Science. Tous les ans, l'institut publie le Journal Citation Reports (JCR), qui établie un facteur d'impact pour chaque revue scientifique suivie.

Mais comment est calculé le facteur d'impact (FI) ?

Le facteur d'impact représente le nombre moyen de citations d'articles récents d'une revue scientifique et donne ainsi une mesure de la visibilité d'une revue scientifique. Il représente le rapport du nombre de citations en un an d'articles d'une revue publiés sur la période des deux ans précédente sur le nombre total d'articles de la revue publiés dans les deux ans précédents. Il est donc calculé sur une période de trois ans.

Prenons un exemple !

Ainsi, pour calculer le facteur d'impact de la revue Nature en 2012, il faut prendre en compte :

X = le nombre de fois que des articles de Nature publiés sur la période 2010-2011 ont été cités en 2012

Y = le nombre total d'articles publiés dans Nature sur la période 2010-2011

On a alors FI = X / Y (l'impact factor de 2012 ne pourra en réalité être connu qu'en 2013, puisqu'il faut attendre la fin de l'année 2012).

Pour avoir un ordre de grandeur, les deux revues scientifiques considérées comme étant les plus prestigieuses sont Nature et Science, qui ont des facteurs d'impact de l'ordre de 30. Certaines revues biomédicales ont des facteurs d'impact plus importants. A l'inverse, nombre de revues de domaines spécialisées ont des facteurs d'impact inférieurs à 5.

La parole est au chercheur-créateur

Eugène Garfield revendiquait à la création de l'impact factor que celui-ci permettrait de simplifier le travail des documentalistes et des bibliothécaires dans le choix des revues scientifiques, arguant du fait qu'ils n'ont pas le temps de lire les articles d'une revue pour les choisir, et que leur choix serait de toute manière subjectif : « When it comes time to evaluating faculty, most people do not have or care to take the time to read the articles any more! Even if they did, their judgment surely would be tempered by observing the comments of those who have cited the work ». Il ne s'attendait par ailleurs absolument pas à ce que ce simple indicateur fasse l'objet d'une controverse, cet indicateur étant initialement construit comme un outil à destination des bibliothécaires. Mais il le reconnaît lui-même, entre de mauvaises mains, il peut devenir dangereux ! « Like nuclear energy, the impact factor is a mixed blessing. I expected it to be used constructively while recognizing that in the wrong hands it might be abused »*.

D'autres indicateurs bibliométriques

Cet indicateur est aujourd'hui couramment utilisé en bibliométrie, avec l'eigenfactor et le h-index. L'eigenfactor fonctionne sur le même principe que l'impact factor, et utilise d'abord les publications du JCR, mais sur une période de cinq années, en excluant les auto-citations d'articles dans une même revue. Le h-index quant à lui s'intéresse plus particulièrement à la visibilité d'un chercheur. Ainsi, un chercheur a un indice de N s'il a publié au moins N articles qui ont été cités au moins N fois. Des chercheurs publiant énormément mais étant peu cités ont donc un h-index faible, de même que des chercheurs ayant publié exceptionnellement un article cité de nombreuses fois. La citation est donc à la base de la mesure en bibliométrie, suivant l'idée que la pertinence d'un article scientifique est confirmée par sa citation par ses pairs.

* « The Agony and the Ecstasy— The History and Meaning of the Journal Impact Factor », Eugène Garfield, 2005, http://garfield.library.upenn.edu/papers/jifchicago2005.pdf

LE FACTEUR D'IMPACT DEPUIS LES ANNÉES 1950

LE FACTEUR D'IMPACT À TRAVERS LE MONDE

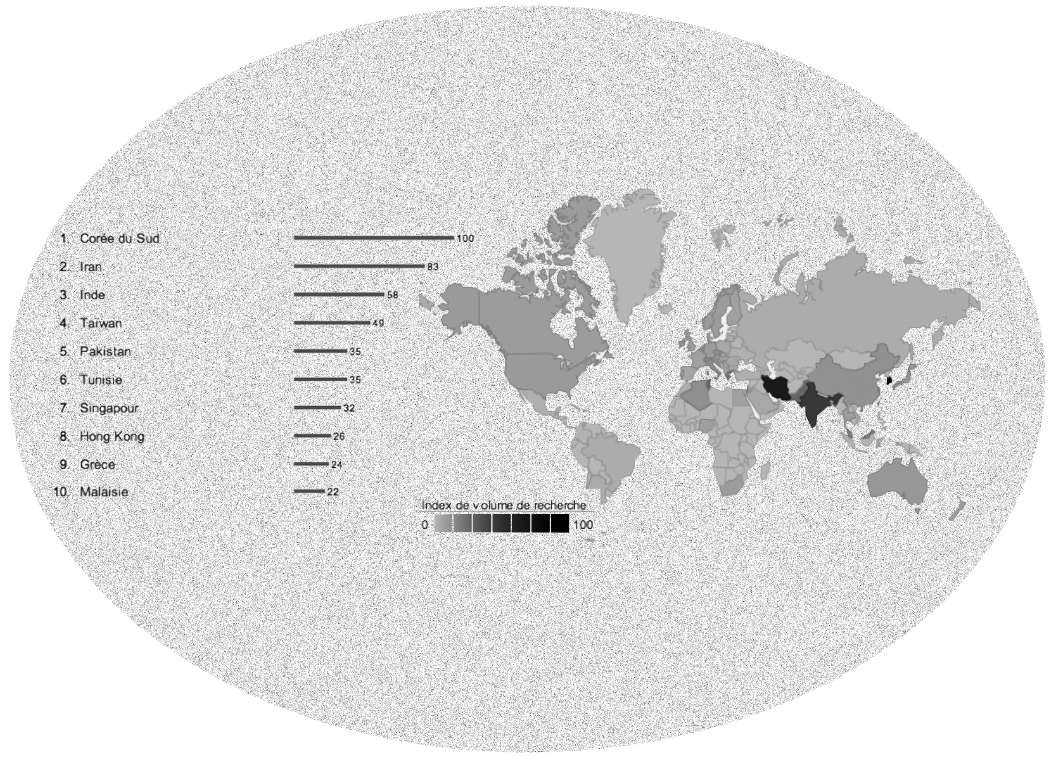

Une mesure de l'intérêt pour le facteur d'impact à travers le monde

Utilisation de Google Insights for Search

L'utilisation de « Google Insights for Search » permet d'avoir une mesure relative de l'intérêt pour un sujet. En effet, cet outil calcule le nombre de « query » (de requêtes) sur Google depuis 2004, comportant les mots-clés, en l'occurrence ici « Impact Factor ». L'usage de cet instrument met en évidence les tendances de recherche et, dans le cas de l'impact factor, les résultats qu'ils révèlent sont particulièrement intéressants.

On aurait légitimement pu penser que le facteur d'impact, créé par un Américain et utilisé dans le domaine des revues scientifiques, principalement anglo-saxonnes, intéresserait, en premier lieu, aux Etats-Unis, au Royaume-Uni, en Occident en général. Le Google Insights for Search montre une tendance inverse : la requête « impact factor » est la plus fréquemment envoyée à Google dans des pays du Proche Moyen et Extrême-Orient ; en tête desquels figurent la Corée du Sud, l'Iran et l'Inde.

On peut supposer que l'intensité, dans ces pays, de recherches sur le facteur d'impact, révèle une prise de conscience, une sensibilité récente, à l'importance du facteur d'impact et de son utilisation, ces dernières années.

Réciproquement, la faible intensité de la query en Europe occidentale et aux Etats-Unis, souligne vraisemblablement que ces pays ont été plus tôt confrontés aux problématiques liées à l'impact factor.

La première observation est donc que, la recherche en Orient et Extrême-Orient s'est, ces dernières années, éveillés aux problématiques liées au facteur d'impact.

La nature de cet intérêt pour l'impact facteur

Utilisation de Google Insights for Search

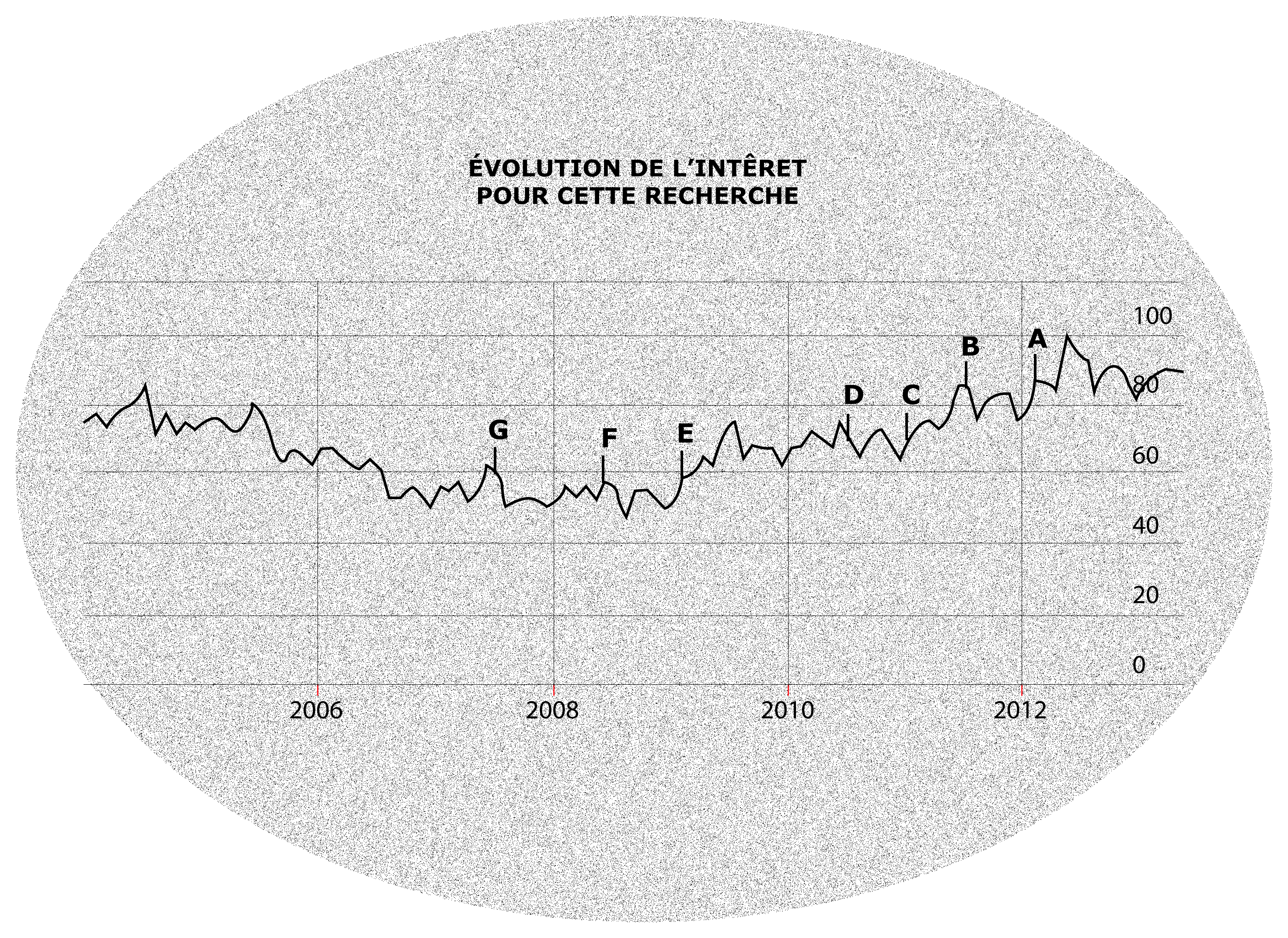

L'instrument de mesure d'une requête – Google Insights for Search – permet également d'afficher l'évolution de l'intérêt pour l'objet, dans notre cas le facteur d'impact, et les query complètes les plus fréquentes comportant les mots-clés « Impact factor ».

Ce tableau met en évidence un regain d'intérêt, depuis 2011, pour l'impact factor, dans les requêtes Google. Par ailleurs, ce tableau indique également à l'intérieur de quelle requête complète le terme « impact factor » est le plus fréquemment utilisé, ces derniers mois ; depuis début 2012, c'est la query « Pimp my impact factor » (de l'anglais familier qui veut dire « augmente mon facteur d'impact »). Ce résultat est très intéressant car il suggère que le regain d'intérêt, sur Google, ces derniers mois, s'expliquerait, en grande partie, par le souci de chercheurs ou de revues de trouver des moyens d'augmenter leur facteur d'impact ; c'est-à-dire d'utiliser, de détourner l'impact factor à leur avantage.

En théorie, une revue ne peut augmenter un indice bibliométrique comme l'impact factor qu'en investissant dans les articles qu'elle publie afin qu'ils soient le plus cités ; un chercheur peut espérer publier dans des revues à fort facteur d'impact que s'il ne traite de thématiques au cœur de l'actualité, et qui vont être discutées.

Le fait que la query la plus fréquemment envoyée sur Google porte sur le moyen d'augmenter son facteur d'impact souligne le fait qu'il puisse exister des mécanismes de dévoiement de cet indice bibliométrique, de son usage initial.

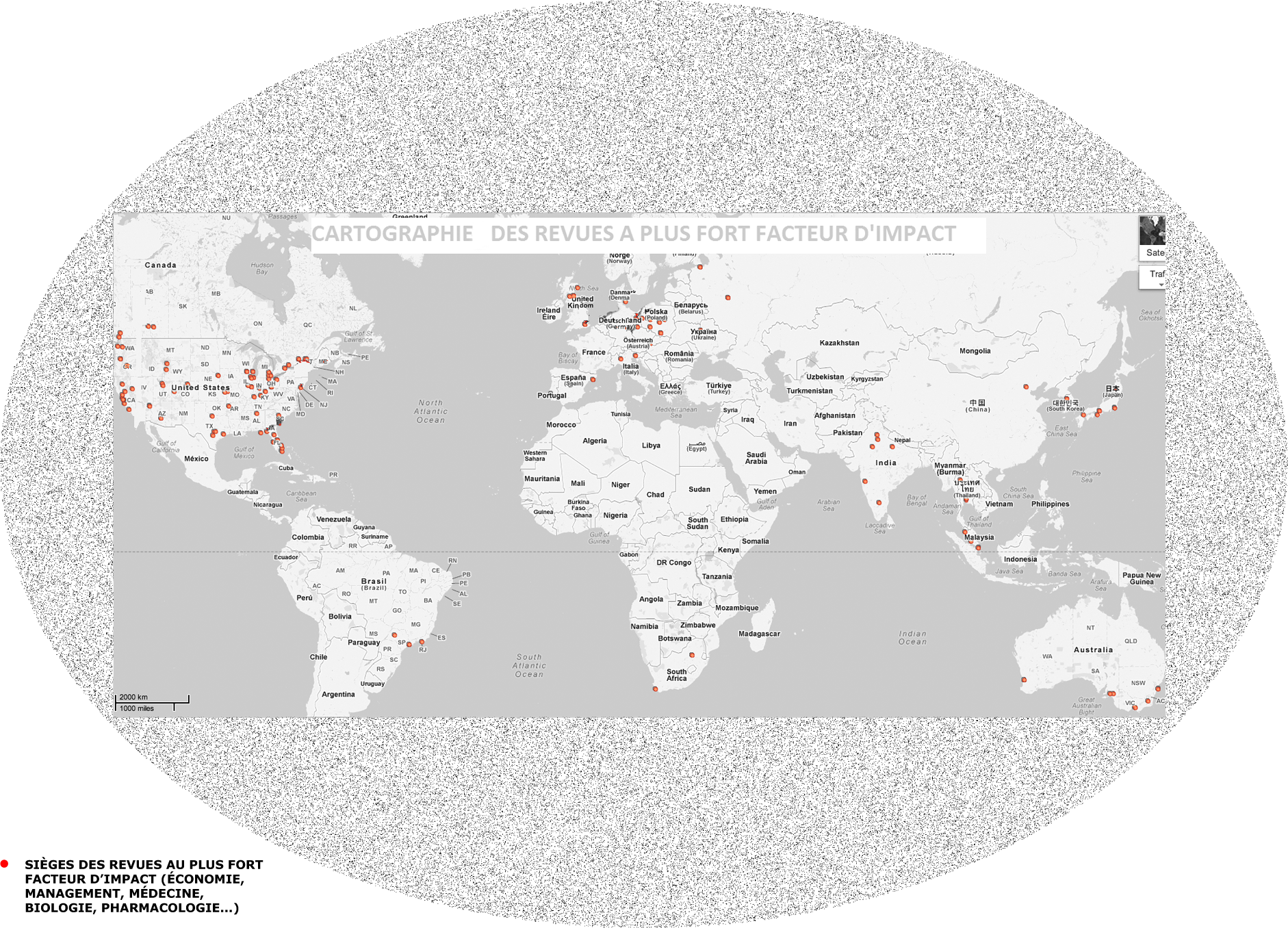

Où sont éditées les revues à fort facteur d'impact ?

Les Etats-Unis dominent très largement cette cartographie des revues à plus fort facteur d'impact ; dans chaque discipline, 3 des 5 revues au plus fort facteur d'impact sont états-uniennes. L'Europe arrive en deuxième position, notamment sous l'effet des facteurs d'impact très élevés des revues éditées dans les pays nordiques. La troisième position revient à l'Inde, qui effectue une percée très remarquée dans le Journal de l'Impact Factor ces deux dernières années.

Cette cartographie révèle, d'une part, la domination des pays dont la recherche est produite en langue anglo-saxonne ; les Etats-Unis et le Royaume-Uni, les pays nordiques dans lesquels l'enseignement supérieur et la recherche se sont convertis à la langue anglaise, l'Inde ancienne colonie de l'empire britannique. Les pays où la recherche résiste encore à l'influence de la langue anglaise, au premier chef desquels la France, souffrent d'un désavantage considérable dans ce classement. Cette cartographie souligne, d'autre part, une évolution récente ; l'apparition massive dans ce classement des émergents – Inde, Japon, Corée du Sud, Brésil. Cette évolution constitue la partie immergée de l'iceberg dont la partie sous-marine était l'éveil, souligné précédemment, des pays d'Orient et d'Extrême-Orient aux problématiques liées au facteur d'impact.

NOTRE ENQUÊTE

Le facteur d'impact est un indicateur bibliométrique qui divise actuellement le monde scientifique. Cet indicateur a été créé pour classer les revues scientifiques et les articles, en fonction du nombre de citations que ces articles obtiennent dans les deux ans après leur parution. Or, ce facteur d'impact est également utilisé dans l'évaluation des chercheurs et dans l'attribution de budget, ce qui est dénoncé par certains scientifiques ou encore certaines institutions. Dès lors, des alternatives sont proposées pour éviter d'évaluer la qualité d'un article en fonction du nombre de citations. Au sein de la communauté scientifique, des acteurs variés s'expriment sur le rôle qu'a ou que devrait avoir le facteur d'impact. Ils sont :

• des chercheurs, qui prennent parti pour ou contre le facteur d'impact. De façon générale, les chercheurs les plus connus possédant un facteur d'impact élevé (environ 5% de la communauté scientifique) encouragent son utilisation.

• les gouvernements, en particulier le ministère de la Recherche. Le ministère encourage le facteur d'impact dans la mesure où il a un aspect pratique : il permet une évaluation et une distribution des budgets rapide.

• Les agences gouvernementales, telles que l'ANR, ou l'AERES utilisent massivement le facteur d'impact dans l'évaluation de la recherche et l'attribution de fonds.

• les institutions non gouvernementales, tels que les collectifs de chercheurs (Sauvons la recherche par exemple)

L'opposition la plus générale concernant le facteur d'impact a lieu entre les scientifiques, qui veulent une certaine liberté de publication, et les autorités (nationales et européennes) qui de plus en plus distribuent leurs aides financières en fonction du facteur d'impact. C'est le cas, en France, avec l'ANR qui attribue les crédits de recherche sur la base de la bibliométrie ou encore le European Research Council.

Ceci mène à une deuxième opposition au sein même des chercheurs entre ceux qui profitent de l'utilisation du facteur d'impact (puisqu'il leur permet d'avoir accès au financement de leurs recherches) et entre ceux qui au contraire sont « pénalisés » à cause de leur faible facteur d'impact.

Nous avons dès lors procédé à plusieurs interviews

Godeffroy Bodenhausen, chercheur à l'ENS

positionné contre le facteur d'impact, il critique son utilisation qui tend à transformer la pratique scientifique. En effet, il dénonce les méthodes utilisées par certains chercheurs afin d'avoir un facteur d'impact plus élevé et donc avoir plus de chances d'être publiés. Dès lors, il préconise un retour à l'évaluation par les pairs.

Ghislaine Filliatreau, directrice de l'OST

Le problème du facteur d'impact selon G. Filliatreau est son usage administratif, c'est-à-dire son traitement comme une donnée statistique. L'OST produit l'indicateur d'impact espéré qui, selon elle, est la bonne utilisation du facteur d'impact.

Audrey Baneyx, enseignante à Sciences Po

Elle s'oppose à l'utilisation actuelle du facteur d'impact, dans la mesure où il ne constitue qu'une vision partielle de la production scientifique. De même, l'indicateur tend à uniformiser la recherche (même tranche d'âge, même nationalités... sont représentées). Toutefois, elle affirme qu'il existe une bonne utilisation de cet indicateur.

Olivier Gandrillon et Alain Polian membres du collectif « Sauvons la recherche »

Fortement opposés au facteur d'impact, ils rappellent la complexité du concept de « qualité scientifique ». Cet indicateur ne permet pas de rendre compte des innovations produites par chaque chercheur.

Somnath Saha, médecin américain, éditeur adjoint du « Journal of General Internal Medicine »

S. Saha se positionne en faveur du facteur d'impact mais admet que le risque d'erreur est très important. Dès lors, il s'oppose à son utilisation dans l'allocation des budgets. De plus, il confirme que les chercheurs qui publient dans « Journal of General Internal Medicine » sont toujours à la recherche de moyens pour augmenter leur facteur d'impact. Enfin, selon S. Saha il est peu probable qu'un autre indicateur puisse remplacer le facteur d'impact dans l'avenir.

Nous avons aussi tenté de contacter d'autres acteurs de la controverse, mais malheureusement nos tentatives ont été infructueuses :

L'agence Reuters

propriétaire du facteur d'impact, il nous semblait important de connaître leur avis sur l'utilisation du facteur d'impact et ses arguments face aux critiques.

Un membre du « Ministère de l'enseignement supérieur et de la recherche »

une des critiques faite par les chercheurs était le fait d'attribuer les fonds de recherche selon le facteur d'impact. Nous souhaitions dès lors rencontrer un membre du Ministère de la recherche pour connaitre le rôle effectif de l'indicateur dans l'allocation des budgets.

Des éditeurs de revues scientifiques

nous souhaitions savoir si le facteur d'impact avait une influence dans le choix de publier un article.

L'INSTRUMENT DES MAISONS D'ÉDITION

À l'origine simple indicateur de popularité, le facteur d'impact s'impose désormais comme une mesure de la qualité d'une revue. Pour comprendre ce détournement, on va s'attacher à retracer l'histoire de l'usage de l'impact factor.

À l'origine, l'instrument des bibliothécaires

Les bibliothécaires sont confrontés quotidiennement au choix des périodiques auxquels s'abonner. Or, dans la profusion de quotidiens, d'hebdomadaires, de mensuels, de trimestriels qui paraissent dans le monde chaque année, comment faire le tri ? Trouver les perles rares ?

Par ailleurs, les bibliothécaires sont soumis à un impératif : l'argent public doit être utilisé efficacement. Par conséquent, les revues adoptées doivent être correctement ciblées pour être lues. D'autant plus en ce qui concerne les revues scientifiques : d'une part, dans la mesure où elles sont relativement coûteuses ; d'autre part, parce qu'elles sont lues essentiellement par des chercheurs qui y puisent leurs objets de recherche ou leurs idées. Elles sont donc un objet de création et de diffusion de la connaissance scientifique.

Mais, rien ne garantit que les choix satisfassent le lectorat. Le meilleur moyen de réduire le risque est donc d'observer ce qui se fait ailleurs ; voir les périodiques qui en moyenne, sont le plus lus, commentés. L'impact factor permet d'observer ces régularités statistiques et est ainsi venu apporter une réponse au besoin d'information qu'exprimaient les bibliothécaires.

Cet extrait du journal de l'impact factor 2011 met en évidence les destinataires premiers du facteur d'impact ; les bibliothécaires. En effet, figure à côté de chaque revue le code ISSN qui permet aux bibliothécaires de commander à partir de leurs ordinateurs, les revues auxquelles ils souhaitent s'abonner.

ISSN (International Standard Serial Number) facilite la gestion informatique des publications dans les bibliothèques et les services de documentation.

Le détournement : l'usage des maisons d'édition

La structure d'une maison d'édition est analogue à celle du portefeuille de n'importe quel actionnaire : la maison d'édition publie plusieurs revues, dont elle souhaite évaluer la rentabilité, de la même façon qu'un actionnaire qui a un portefeuille d'actions diversifié compare quelle action lui rapporte les dividendes les plus élevés. L'impact factor, indice de popularité de la revue, indique à la maison d'édition, quelles sont les revues qu'elle publie, qui sont les plus lues, les plus commentées, et par conséquent, les plus efficientes financièrement. À l'instar des actionnaires, la maison d'édition décide de délaisse les « actifs financiers » (les revues) les moins rentables et de développer les plus efficientes. Mais, à l'inverse des actifs financiers, les revues ne sont pas interchangeables, neutres, vides de contenu. Par conséquent, il faut justifier auprès des abonnés, des lecteurs occasionnels et des professionnels les raisons du choix qui poussent les maisons d'édition à investir dans une revue et désinvestir d'autres. Dans le monde de la recherche scientifique, la justification financière peut être frappée d'illégitimité. C'est pourquoi, les maisons d'édition explicitent leurs choix en termes de qualité des différentes revues. Les maisons d'édition introduisent le détournement de cet indice quantitatif qu'est l'impact factor, en un indice qualitatif.

INDICATEUR OU STATISTIQUE ?

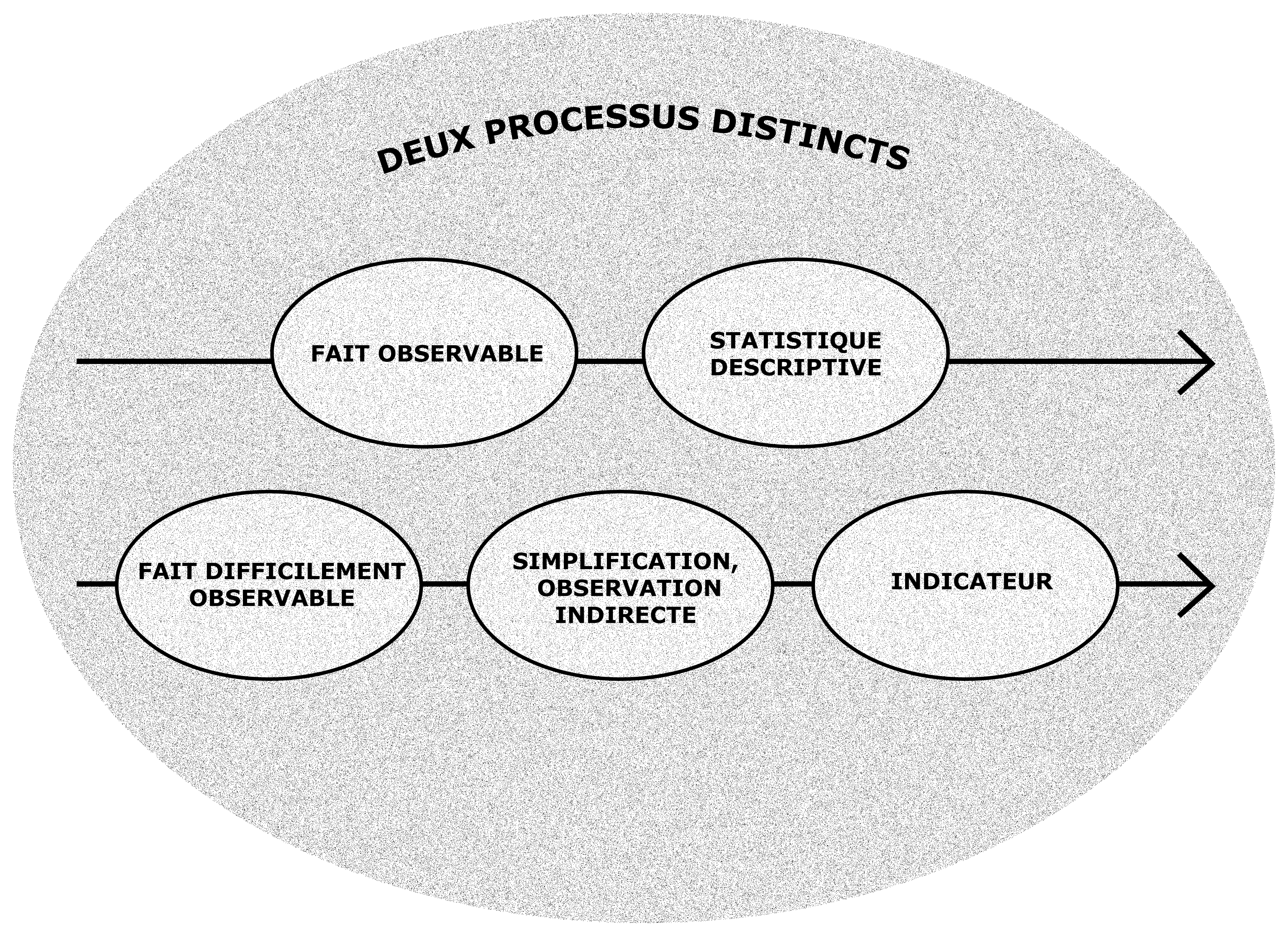

Un des points clés de la controverse réside dans le fait que beaucoup n'opèrent pas la distinction qu'il convient d'effectuer entre un indicateur et une statistique descriptive. Si ces deux objets prennent la même forme, celle d'un chiffre, leurs utilisations doivent être radicalement opposées tant leurs natures sont différentes.

Une statistique est par essence descriptive, il s'agit d'une forme de dénombrement dont la validité ne peut être contestée dans la mesure où elle ne laisse aucune place à l'interprétation humaine. Elle procure une information brute, qui peut ensuite être traitée et administrée comme une donnée, comme un fait extérieur à son lecteur. C'est le cas de la population, de l'altitude, etc.

Dans le cas d'un indicateur au contraire, des choix se dissimulent derrière le chiffre. On ne peut lire un indicateur de manière satisfaisante qu'à la lumière de ces postulats. Les indicaturs sont indissociables de l'interprétation de celui qui les lit. C'est le cas des indicateurs de chômage par exemple, que l'on a choisi de calculer en fonction de la population active, plutôt qu'au regard de la population globale. C'est en cela que les indicateurs sont sujets à débat : qui dit interprétation dit subjectivité et donc incompréhensions potentielles.

Le facteur d'impact fait sans conteste partie de la seconde catégorie, celle des indicateurs. Comme nous l'avons vu précédemment, les maisons d'édition ont eu tout intérêt à opérer l'amalgame entre la citation et la qualité pour des questions de profit et de prestige. C'est précisément dans ce glissement que réside le passage d'une statistique à un indicateur : d'un simple dénombrement permettant d'obtenir la fréquence de citation, on obtient un indicateur de qualité d'une revue. Le présupposé est ici bien visible : on assimile la citation à la qualité. A partir de là, toute utilisation du facteur d'impact qui ne tient pas compte de ce choix – qui peut par ailleurs se justifier – est sujette à reproches. C'est bien, selon Ghislaine Filliatreau, le problème des agences gouvernementales chargées de l'attribution des fonds de recherches : dans un souci d'objectivation de leurs décisions, elles omettent ce postulat et administrent les facteurs d'impact comme des données statistiques, ce qu'ils ne sont absolument plus. Une importante ligne de faille apparaît donc entre les différents acteurs du fait de cet oubli – volontaire ou pas – motivé par l'efficacité et la nécessité de la décision.

Une autre séparation peut s'expliquer par cette distinction : celle de l'écart qui existe entre sciences dures et sciences sociales dans l'utilisation des indicateurs bibliométriques et notamment du facteur d'impact. Les indicateurs sont intrinsèquement liés à la démarche expérimentale. Il s'agit toujours d'approximer un fait, dont la mesure directe est impossible, par un proxy, un indicateur. On ne peut pas mesurer directement la qualité d'un article, on l'approxime donc par la citation. Il s'agit d'une démarche très souvent utilisée en sciences physiques ou en biologie, avec par exemple l'utilisation d'indicateurs colorimétriques pour mesurer le pH. C'est sans doute un facteur explicatif très important pour ce qui concerne la familiarité des indicateurs avec les domaines tels que la biologie et la médecine ainsi que l'aversion des sociologues ou des philosophes à l'endroit de ces mêmes indicateurs. Le rapport au chiffre de la discipline conditionne en grande partie le rapport à l'indicateur. +

UN CONSTAT PARTAGE : L'HISTOIRE D'UN DETOURNEMENT

CERCLE VERTUEUX OU CERCLE VICIEUX ?

L'impact factor est un indicateur bibliométrique. Il se propose de répondre en outil quantitatif à un besoin d'information. La production scientifique étant toujours plus conséquente et le nombre de revues scientifiques toujours plus grand la communauté scientifique ressent en effet le besoin de classer toute cette information et de pouvoir faire facilement le tri. L'impact factor se veut donc un outil permettant aux meilleures publications d'émerger et donc permettant à la production scientifique de s'inscrire dans un cercle vertueux où le classement entre les différentes revues scientifiques ne seraient dû qu'à des critères objectifs, venant remplacer des critères subjectifs tels que l'inertie historique : les chercheurs ne lisant que certaine revue par habitude et non en raison de la qualité de ces dernières. L'impact factor serait un outil de remise en cause d'un processus de publication et de lecture vu comme potentiellement fallacieux.

Cependant, l'impact factor n'est pas à l'abri de tout abus ou de toute instrumentalisation. En effet, lorsque l'on analyse sur google inside research les mots les plus souvent associés sur google au terme « impact factor » son « pimp my » (i.e « améliorer mon »). Ceci est bien exemplaire du fait que cet outil fait l'objet d'instrumentalisation ou du moins d'une utilisation qui voudrait, au-delà de la qualité des articles publiés, dans la revue améliorer le niveau de l'impact factor de cette revue.

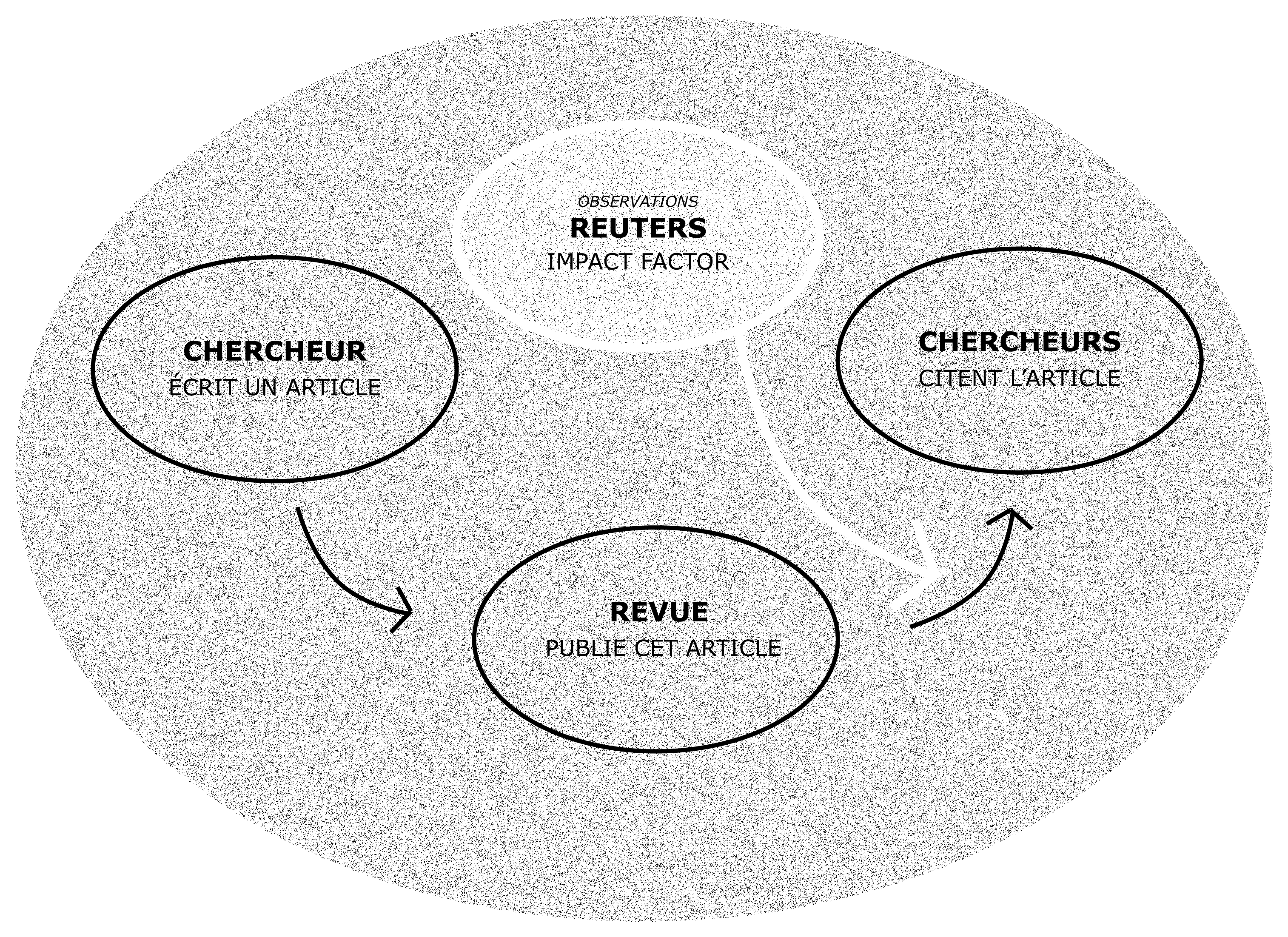

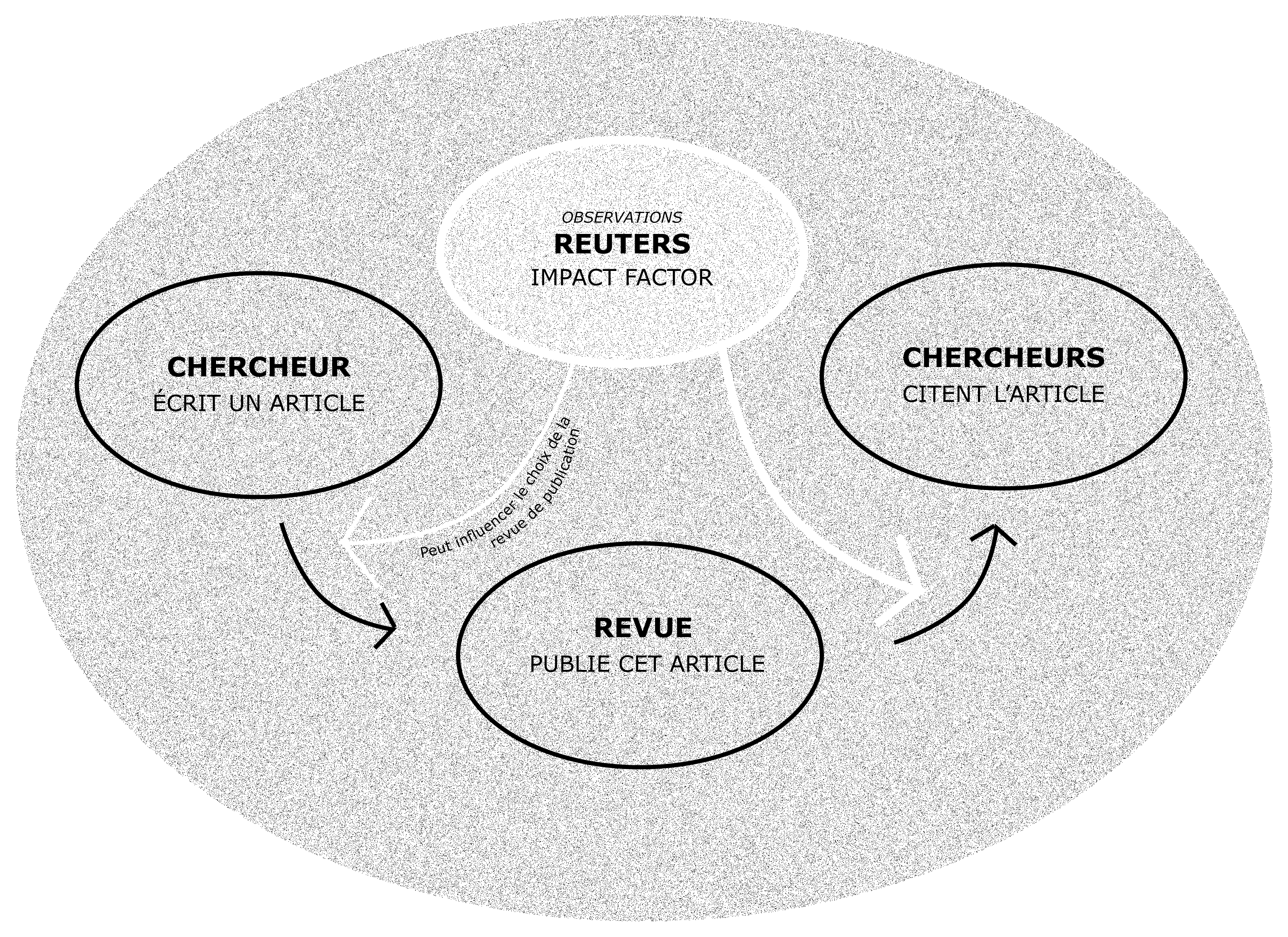

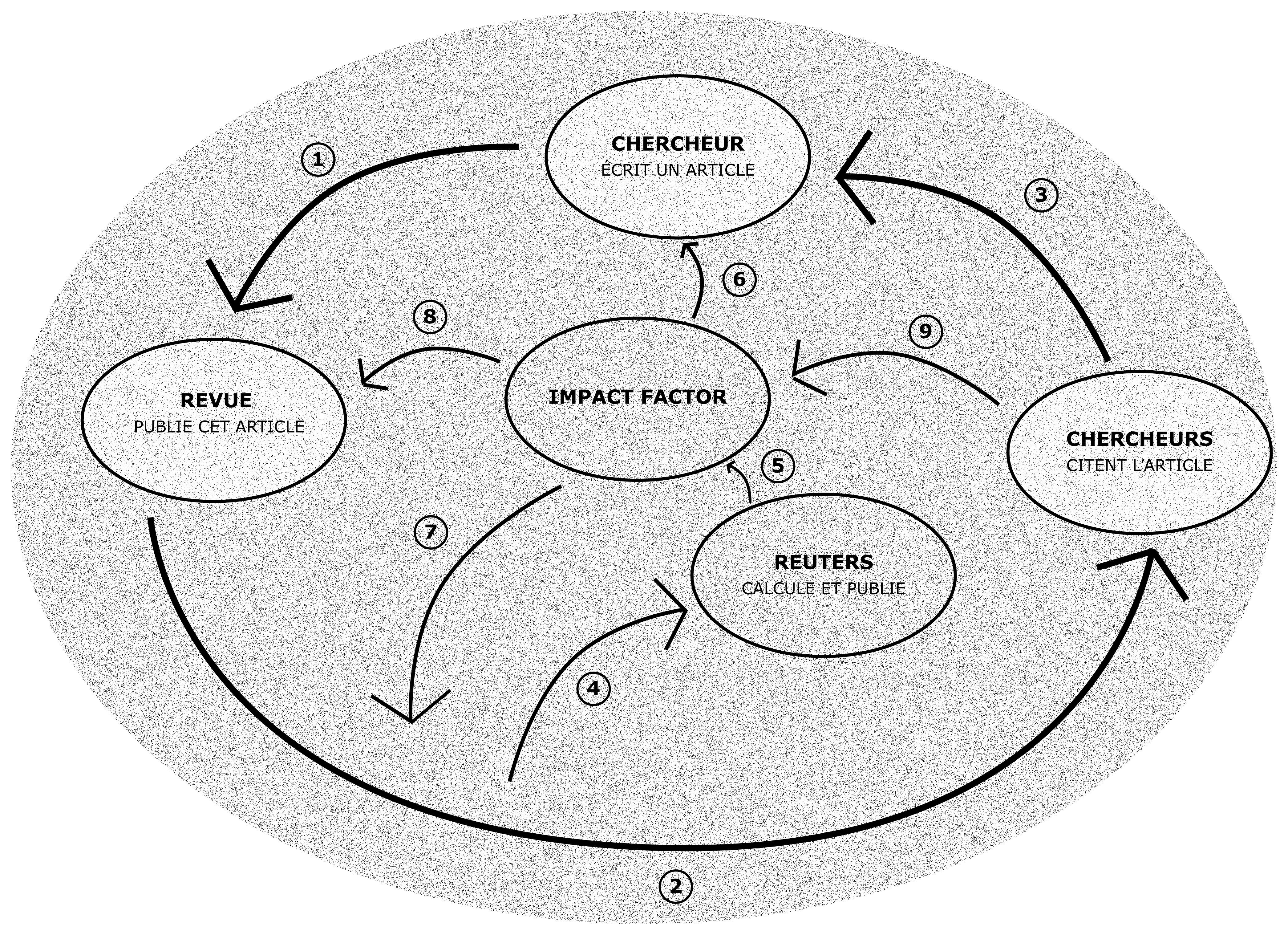

Dans quelle mesure l'impact factor influence-t-il le déroulement et la structure du processus de publication scientifique ?

Nous verrons que si Reuters présente l'impact factor comme un outil d'observation des grandes tendances de la publication scientifique, les acteurs critiques vis-à-vis de l'impact factor en font le moteur d'un chemin de dépendance et de circonvolution vicieuse de la publication scientifique.

Les principaux tenants de la première thèse faisant de l'impact factor un outil de la circonvolution vertueuse de la publication scientifique sont ceux qui tirent profits de son utilisation. Les relayeurs de cette thèse sont donc avant tout Eugène Garfield, l'inventeur de l'impact factor et le fondateur de Institute for Scientific Information (ISI), et Reuters, l'entreprise ayant racheté l'ISI et calculant l'impact factor de la plupart des revues scientifiques.

Pour eux, l'impact factor est un outil qui permet de faire une sélection « rapide et efficace » parmi l'important nombre de citation scientifique. Il présente la mesure de la citation comme « processus de sélection est neutre », qui permettrait de faire un classement sans a priori de la recherche scientifique en laissant aux scientifiques de faire eux-mêmes leur choix. Pour eux, l'impact factor n'est seulement que la retranscription des tendances des chercheurs et na donc pas de conséquence sur les comportements des chercheurs. L'utilisation de l'impact factor est ici présentée comme une simple objectivation sans moindre influence dans le processus de publication scientifique. Ils s'opposent ainsi à la théorie de l'acteur réseau, qui conçoit les objets d'une controverse comme des acteurs à part entière de celle-ci.

Par ailleurs, Reuters présente l'impact factor comme un outil de la recherche.

L'impact factor est en dehors de la recherche.

Les institutions d'évaluation de la recherche comme O.S.T ou l'AERES ont une position intermédiaire qui bien qu'ayant conscience des effets de l'impact factor, lui accorde un rôle moindre dans le processus de publication scientifique.

À l'inverse, les chercheurs critiquent vis-à-vis de l'impact factor ont une perception plus grande du rôle de l'impact factor dans le processus de publication qui est vu comme une suite de cercle concentrique et entremêlés.

1 . Un chercheur soumet un article à une revue scientifique.

2 . La revue peut choisir de publier l'article proposé par le chercheur. Ce choix se fait maintenant notamment en pensant à son facteur d'impact (8).

3 . Des chercheurs citent dans leurs articles l'article publié par la revue. Cette citation permet à l'auteur de publier d'autres articles en citant lui-même les auteurs qui l'ont cité.

4 . Reuters analyse les citations des articles publiés dans les revues.

5 . Il produit un indicateur : l'impact factor.

6 . Les chercheurs lisent le journal de l'impact factor et repères les revues qui sont le mieux classée via cet indicateur. Ils choisissent donc les revues dans lesquelles ils souhaiteraient être publiés.

7 . Les chercheurs sont incités par les revues à citer dans leurs articles des articles ayant été publiés dans leurs revues, pour augmenter leur propre impact factor.

8 . Les revues adoptent des politiques et des lignes éditoriales pour améliorer leur visibilité et leur impact factor.

9 . Les chercheurs choisissent les revues scientifiques qu'ils vont lire en fonction de l'impact factor de celles-ci, ce qui augmente la probabilité qu'ils citent dans leurs propres articles des articles de revues à haut impact factor.

Les revues avec un meilleur factor d'impact sont structurellement avantagées selon la grille de lecture des adverses de l'utilisation de l'impact factor.

LE CHIFFRE ET LA DÉCISION

La statistique et les mathématiques sont souvent présentées comme un outil neutre. En effet, les sciences, interprétations du réel, sont par essence sujettes à une contingence culturelle. Les mathématiques se veulent et se présentent comme une suite de raisonnements logiques et nécessaires et donc essentiellement neutres politiquement ou culturellement. C'est bien pourquoi ces outils se sont vites imposés comme éléments d'une prétendue objectivisation des mécanismes régissant le monde. Mais l'émergence même de la statistique et des mathématiques comme instrument est éminemment contingente et n'est donc pas neutre. De plus, ces outils et en particulier les indicateurs bibliométriques comme l'impact factor ont une valeur performatrice, ils influent sur et modifie cela même qu'il prétende observer.

En quoi les indicateurs bibliométriques en tant qu'outils numériques ont-ils pu s'imposer dans le processus décisionnel de la recherche ? Et pourquoi sont-ils critiqués ?

La caractéristique numéraire et numérique de l'impact factor répondant d'abord à un besoin de classement de publications toujours plus nombreuses a permis à l'impact factor, et les indicateurs bibliométriques en général, de s'imposer dans le processus décisionnel de l'évaluation de la recherche scientifique.

Durant les soixante-dix dernières années, la démocratisation de l'enseignement supérieur, les évolutions techniques et la mise en commun des connaissances à l'échelle planétaire ont été parmi d'autres des facteurs favorisant une explosion des publications scientifiques. Face à cette publication en explosion s'est donc développé le besoin d'outils permettant de faire un tri parmi cette littérature scientifique devenant techniquement illisible. C'est alors que les indicateurs bibliométriques, tel que l'impact factor, se sont imposés comme outils, perçus comme neutres, parce que statistique et mathématique, de classement de la littérature scientifique. Il s'est d'ailleurs d'abord imposé chez les bibliothécaires des universités scientifiques américaines qui ne savaient à quelles revues s'abonner en priorité. La force des ces outils réside essentiellement dans le fait qu'ils sont numériques. En effet, cela permet d'établir un classement précis des différentes revues. De plus, ils donnent à voir clairement et sans possibilité de critique les méthodes de calcul qui lui sont inhérentes. Ils sont donc placés hors de toute critique.

C'est la même logique qui a abouti à l'imposition de ces indicateurs et de l'impact factor en particulier, dans l'évaluation de la recherche et en particulier dans le processus d'allocation des subsides étatiques. L'État s'est vite imposé comme un acteur important du mécénat de la recherche scientifique. Il s'est donc construit un modèle de financement de la recherche scientifique qui accordait une part importante à l'investissement étatique. Sur ce modèle, s'est développée une communauté de chercheurs scientifiques toujours plus importante. Parallèlement, l'État soumis à des logiques de restrictions budgétaires à restreint son soutien à la recherche et laisser une place toujours plus importants aux acteurs non-étatiques et financiers dans le financement de la recherche scientifique. Cette évolution a entrainé une advenue des logiques des investisseurs privées dans la sélection des recherches à financer. Ces acteurs extra-scientifiques voyaient dans les indicateurs bibliométriques un outil permettant de ramener une réalité scientifique (et donc étrangère pour eux) à une réalité en affinité avec leur monde mue par une réalité dominé par les chiffres.

Après ce récit linéaire de l'imposition des indicateurs bibliométriques dans l'évaluation de la recherche scientifique, il ne faudrait pas croire que ceux-ci font consensus, bien au contraire. Mais là encore, il y a deux types de critiques. D'un part, celles qui remettent en cause le calcul même de l'impact factor ou l'opacité de celui-ci. D'autre part, certaines critiques vont jusqu'à remettre en cause l'utilisation même d'outils mathématiques pour juger de la qualité de la recherche scientifique. Ils refusent la réduction d'une réalité complexe et par essence multidimensionnelle et multifactorielle à une entité numérique telle que la valeur de l'impact factor. Ils critiquent d'ailleurs l'utilisation de la citation, réalité complexe qui peut avoir plusieurs raisons, comme d'une réalité binaire et numérique. Cela ne signifie pas la même chose de citer un article pour le prendre en exemple ou pour le critiquer.

La puissance des indicateurs et des nombres est aussi leur plus grande faiblesse. Ils permettent certes de réduire à une réalité très facilement analysable, une réalité éminemment complexe et difficilement lisible. Mais cette réduction se fait au détriment de la réalité même. En voulant réduire les faits scientifiques, ils ne les sauvent pas.

L'imposition de ces indicateurs s'explique par une tension importante sur le besoin d'information créé par l'explosion de la littérature scientifique et par une imposition d'acteurs non-scientifiques dans le processus de financement et d'évaluation de la science.

LES CRITIQUES MÉTHODOLOGIQUES

Lors de notre enquête, la plupart des scientifiques se positionnant contre l'usage du facteur d'impact, en particulier au sein du collectif Sauvons la recherche, nous ont décrit les limites méthodologiques du facteur d'impact auxquelles ils sont confrontés. Au-delà d'une critique sur l'utilisation d'indicateurs bibliométriques en général, ces défauts concernent le calcul du facteur d'impact en lui-même.

Un des premier biais du facteur d'impact est la période courte prise en compte pour le dénombrement des citations. Ainsi, le facteur d'impact comptabilise les citations d'un article pendant deux ans. Or, un article novateur peut être reconnu bien après cette période de deux ans. C'est notamment l'exemple des travaux d'Einstein sur la relativité, donné par G. Bodenhausen (lien vers l'interview en Annexe) lors de son interview. En effet, si le travail d'Einstein est reconnu comme fondateur aujourd'hui, son facteur d'impact aurait été très faible, les articles produits n'ayant été reconnus que longtemps après leur parution. L'impact factor ne permettrait donc pas de repérer le nouvel Einstein.

Selon certains chercheurs, un autre défaut majeur du facteur d'impact est qu'il favorise les sujets « à la mode ». Ainsi, un très bon article traitant d'un sujet qui intéresse peu de chercheurs sera peu cité et donc aura un faible facteur d'impact, malgré sa qualité intrinsèque.

La barrière de la langue est également à prendre en compte. En effet, les chercheurs ne rédigeant pas leurs articles en Anglais sont largement désavantagés par le système du facteur d'impact. Leurs articles, rarement lus par la communauté anglo-saxonne des chercheurs, sont rarement cités, et obtiennent des facteurs d'impact faibles, indépendamment de leur qualité.

Un autre biais très important du facteur d'impact est que les articles cités par les chercheurs ne le sont pas forcément pour de bonnes raisons. Ainsi, un article très mauvais, voire faux, peut être cité par de nombreux scientifiques qui s'en servent comme contre-exemple dans leur démonstration. Ces mauvais articles auront donc un facteur d'impact très élevé, voire plus élevé que celui d'articles justes.

Enfin, d'autres caractéristiques méthodologiques du facteur d'impact peuvent biaiser la représentation de la qualité d'un article, ou encore des qualités d'un chercheur. Ainsi, des problèmes liés à l'homonymie (dans les noms des chercheurs) ou encore liés aux noms composés de ceux-ci sont souvent signalés.

Les confusions liées au calcul du facteur d'impact sont donc nombreuses et ces critiques méthodologiques sont soulevées par des acteurs très divers au sein de la controverse.

Aux vues de l'importance de cet indicateur dans l'évaluation de la recherche, tous ou presque s'accordent sur l'importance d'une refonte méthodologique du facteur d'impact pour le rendre plus juste.

L'INERTIE HISTORIQUE

Au regard des différentes critiques méthodologiques décrites précédemment quant à l'impact factor, une première réponse peut être avancée quant à l'utilisation toujours massive de l'impact factor dans l'évaluation des chercheurs et de la recherche, celle de l'inertie historique.

La théorie de la dépendance des sentiers

Cette inertie historique est définie comme le processus de développement d'une technologie qui est sensible au micro-évènements qui se produisent dans les stades initiaux de son développement, c'est-à-dire que le passé a prédéterminé. Elle est expliquée par Paul A. David dans « Clio and the economics of QWERTY ». Ainsi, certains évènements en apparence anecdotiques au cours de l'émergence d'un objet technique permettraient d'expliquer pourquoi cet objet a pris une telle importance par rapport à d'autres objets techniques qui pourraient paraître plus optimaux. Cette théorie a été mise en place pour expliquer des « échecs de marché », le marché retient des objets qui ne sont pas les plus optimaux, du fait de l'influence d'évènements passés.

L'impact factor et le clavier QWERTY, deux objets techniques, une même trajectoire historique ?

Dans le cas du clavier QWERTY, il s'est imposé, pour deux facteurs historiques. Initialement créé pour les machines à écrire afin d'avoir des touches bien réparties. Ensuite, Franck McGurin a gagné un concours de dactylographie avec ce clavier et l'idée s'est imposée qu'il s'agit du clavier permettant d'écrire le plus vite possible. De ce fait, la standardisation a fait que c'est ce clavier qui s'est imposé par rapport à tous les autres.

La question est donc la suivante, l'impact factor a-t-il également été l'objet de facteurs historiques expliquant son importance en tant qu'indicateur bibliométrique ?

Le « lock-in » de l'impact factor

Les revues précédentes ont pointé l'émergence du besoin d'indicateurs fondés sur des méthodes mathématiques et statistiques, car sources d'objectivité, tout en pointant les défauts de l'impact factor. L'impact factor étant couramment employé dans le monde de la recherche, une inertie historique peut donc également expliquer son utilisation.

Le fait est qu'à sa création, Eugène Garfield figurait parmi les pionniers s'intéressant à ce genre d'indicateurs, bien avant l'effervescence des besoins du monde de la recherche pour l'évaluation.

Publiant une revue annuelle, l'ISI a ainsi permis d'imposer l'impact factor parmi les bibliothécaires tout d'abord, puis parmi les éditeurs et les chercheurs, étant donné sa disponibilité. Le rachat par Thompson Reuters a également apporté un soutien financier, autant qu'une visibilité importante.

Des évènements passés irréversibles ?

La comparaison de l'impact factor et l'inscription de l'impact factor dans la théorie de la dépendance des sentiers pourraient apporter une conclusion à la controverse d'un point de vue méthodologique, car Paul A. David parle « d'évènements passés irréversibles » par rapport à l'inertie historique. Ainsi, l'utilisation de l'impact factor ne pourrait pas être discutée puisqu'il n'y aurait aucun moyen d'arrêter d'utiliser l'impact factor.

Cependant, il existe une différence de taille par rapport au clavier QWERTY. L'impact factor est un outil mathématique, une formule, on peut donc la changer, et cela ne fera que modifier les prochains rapports annuels. La revue précédente a présenté un certain nombre de critiques méthodologiques sur le calcul même de l'impact factor, qui pourraient être prise en compte en corrigeant la formule de l'impact factor.

Ainsi, la comparaison de l'impact factor avec l'hypothèse de l'inertie historique permet de comprendre pourquoi l'impact factor s'est imposé par rapport à d'autres indicateurs bibliométriques, dont certains ont déjà été présentés. Elle n'apporte cependant pas une solution à notre contreverse, et tel n'est pas notre but fondamental ici, mais un éclairage sur la compréhension de cette controverse d'un point de vue méthodologique.

Notre adaptation de la théorie ne rejette pas les propositions de modification du calcul de cet indicateur, nous permettant de parler d'un camp de la réforme pour cette partie de la controverse.

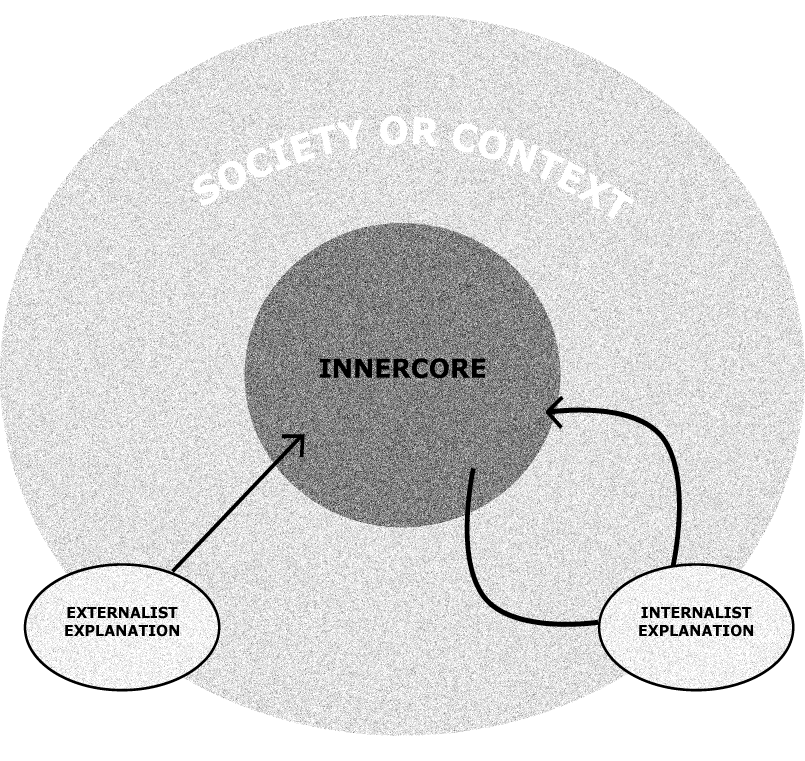

SCIENCE ET SOCIÉTÉ

L'acceptation ou non du principe du facteur d'impact est révélateur de l'existence de conceptions différentes du monde de la recherche, et en particulier du lien que celui-ci doit ou non entretenir avec l'ensemble de la société.

Nous avons précédemment étudié les positions des partisans d'une réforme de l'impact factor. Cette première catégorie d'acteurs accepte le postulat lié à la pratique du facteur d'impact, qui est que le nombre de citations est représentatif de la qualité d'un article. C'est une amélioration de l'impact factor en lui-même et de son calcul qu'il faut alors effectuer, son principe général n'étant pas remis en question.

Cette première vision peut être associée à une tradition philosophique particulière, une vision de la science et de son lien avec la société. La science serait un moyen de servir la société, notamment en s'adaptant aux sujets qui intéressent un maximum d'acteurs. Se baser sur l'impact factor, et en particulier sur le nombre de citations, serait ainsi un bon moyen de connaitre les principaux centres d'intérêts des lecteurs et de les mettre en valeurs. En effet, le nombre de citations d'un article parait significatif de son succès. Un article qui a un faible impact factor, et donc qui intéresse peu de monde, est moins utile à la société même s'il est juste scientifiquement.

Cependant, une autre tendance s'oppose à cette première philosophie. Pour certains, la science doit en effet être uniquement une recherche de la vérité, qui ne doit pas se laisser influencer par la société. Ces deux positions opposées sont représentées sur le schéma, la flèche droite représentant l'influence de la société sur la sphère scientifique, tandis que la seconde flèche représente un repli du monde scientifique sur lui-même.

Cette deuxième tendance peut être mise en parallèle avec un deuxième groupe d'acteurs de notre controverse : les partisans d'une révolution dans l'évaluation de la recherche. Selon ces acteurs, représentés en particulier par les collectifs de chercheurs, du type Sauvons la recherche, l'évaluation de la recherche doit être faite par les pairs. Ainsi, le monde scientifique est évalué uniquement par lui-même et non par la société dans son ensemble, et le succès auprès d'acteurs extérieurs de certains sujets n'est pas pris en compte.

C'est cette deuxième catégorie d'acteurs, partisans d'une suppression définitive du facteur d'impact, ainsi que leurs positions que nous présentons dans ce second temps de l'étude de notre controverse.

Source: « Science's Blood flow » in Pandora's Hope, Bruno Latour

LE RÔLE DE L'ARGENT

L'argent est la condition même de la recherche scientifique : sans moyen financier, il est tout bonnement impossible pour un scientifique de mener à bien sa mission. Par ailleurs, les maisons d'éditions et les propriétaires d'indicateurs bibliométriques cherchent avant tout le profit. L'argent est donc un enjeu majeur de la controverse autour du facteur d'impact : qu'on débatte de son utilisation ou de son influence, il explique une grande part des tensions qui se font jour quand on vient à parler du facteur d'impact.

Pour le dire en des termes marxistes, le problème est celui de la répartition de la valeur ajoutée produite par les scientifiques. Une critique redondante dans les interviews que nous avons pu réaliser s'en prend aux profits colossaux réalisés par les maisons d'éditions et en particulier Thomson Reuters. Il s'agirait d'une forme d'exploitation par les maisons d'édition des fruits du travail scientifique, matérialisés par le succès des parutions. Dans l'esprit de certains, comme par exemple le collectif Sauvons la Recherche , la séparation s'exprime bien en ces termes : les scientifiques, pour qui la publication est vitale et consubstantielle à leur profession, sont spoliés par les éditeurs qui réalisent des profits frôlant l'indécence.

Le facteur d'impact, quant à lui, se maintiendrait puisqu'il profite à ceux qui, seuls, auraient le pouvoir d'abolir son hégémonie : les maisons d'éditions, les compagnies comme Thomson Reuters et les revues à fort facteur d'impact. En effet, l'indicateur, dès lors qu'il reflète la qualité par delà la citation, devient un signal d'achat : une revue à fort facteur d'impact se vend beaucoup. On n'achète plus une revue parce qu'elle est de bonne qualité – acte qui devrait faire grimper son facteur d'impact - mais parce que son facteur d'impact est haut. C'est donc un mécanisme auto-entretenu que les « bien lotis » n'ont aucune raison de briser puisqu'il permet la démultiplication des profits par la naturalisation de la hiérarchie établie par le facteur d'impact. Parmi eux, on trouve même certains scientifiques qui, se trouvant avantagés par le système, ont vu tout le profit qu'ils pouvaient en tirer.

Sans aller jusqu'à faire une interprétation marxiste de la controverse, il semble idéaliste de penser que la répartition des bénéfices ne joue aucun rôle dans les tensions observées entre le monde la recherche et les maisons d'édition. Si la marchandisation de la recherche pose un problème d'ordre philosophique, l'attribution des fonds et l'accaparement de ceux-ci par les éditeurs fait, à un niveau bassement matérialiste, couler beaucoup d'encre. L'argent est donc un acteur à part entière, dans la mesure où il influence les décisions des protagonistes de la controverse.

UNE QUESTION DE VALEURS

Au-delà de l'application d'un schéma marxiste à notre controverse, il s'agit ici de souligner une controverse sur un certain nombre de valeurs. La pratique de l'impact factor implique des positionnements et des critiques d'ordre plus philosophique sur la place, le rôle et l'indépendance du scientifique par rapport à la société.

Un rôle moteur dans la recherche scientifique

L'impact factor joue un rôle d'interface, de messager de la recherche scientifique, puisqu'il permet simplement pour les agents qui en sont extérieurs de connaître les chercheurs qui ont une notoriété importante dans la recherche (étant plus souvent cités), mais aussi les domaines et les sujets scientifiques.

Influer sur le scientifique

L'impact factor n'est pas un indicateur d'évaluation de la production scientifique purement utilisé entre les chercheurs, mais aussi par des éditeurs, des ministères, des fonds privés, en somme des profanes puisqu'ils n'appartiennent pas au monde des scientifiques.

Ils en sont extérieurs car ils ne sont pas dans la pratique du monde scientifique, mais cet indicateur permet d'en avoir un aperçu, en identifiant des chercheurs et des publications à fort impact factor.

Profanes et scientifiques se retrouvent donc liés, et étant donné que c'est à partir de cet indicateur que le profane décide de la notoriété des chercheurs, cela permet d'exercer une influence sur le monde de la recherche.

L'impact factor est donc un instrument qui questionne la position de la science par rapport à la société, car si l'indicateur permet d'influencer la science de l'extérieur, on penche donc vers le modèle d'une science qui répond aux besoins de la société.

Pour les adversaires à ce modèle-type au contraire, l'impact factor est néfaste car il éloigne la science de sa quête de la vérité, qui ne peut supporter de pressions sociales. La science n'à pas à s'orienter dans des directions sources de retombées économiques pour la société. Elle doit prendre le chemin d'une recherche fondamentale économiquement et socialement désintéressée, mais orientée vers la vérité.

Si la nécessité de se passer d'agents financeurs apparaît difficile, certains chercheurs revendiquent cependant leur but "noble", face à des chercheurs presque corrompus, puisque détournés de leur recherche de vérité, par leur recherche de ressources économiques.

L'instrument de l'impact factor, par son influence sur la recherche scientifique, fait donc l'objet d'une controverse se rapportant à ce que doit être le but et l'indépendance de la science par rapport aux profanes qui pourtant la financent, membres de la société.

La mesure du scientifique, une domination ?

Mais au-delà des aspects purement économiques qui permettent d'influer sur la recherche de l'extérieur, la mesure de la recherche par l'impact factor devient un élément de domination sur lui. En effet, mesurer, évaluer la recherche scientifique c'est la diriger, l'orienter et donc la dominer.

La controverse autour de l'impact factor a donc une dimension clairement philosophique, portée sur les conséquences de l'utilisation de l'impact factor.

L'évaluation scientifique n'est pas nouvelle, les chercheurs les plus opposés à l'impact factor pensent eux-mêmes que la recherche scientifique doit être soumise à l'évaluation, pour l'allocation des fonds de recherche, mais aussi éventuellement pour permettre de conseiller les chercheurs qui s'orientent dans des directions fallacieuses, les interviews de Geoffrey Bodenhausen et Olivier Gandrillon le soulignant. Alors en quoi l'impact factor est-il particulièrement concerné ?

Le fait est que la construction de cet indicateur permet une intervention exogène dans le milieu scientifique. L'évaluation des centres de recherche a longtemps passé par les pairs, dans une volonté d'approche qualitative, où les équipes d'évaluation prenaient le temps de comprendre la démarche du chercheur, de lire ses publications, d'avoir des entretiens avec lui.

Même si ces formes d'évaluation qualitative ne sont pas complètement abandonnées, le fait est que les indicateurs bibliométriques dont l'impact factor fait partie permettent deux choses. D'une part ils rendent l'évaluation beaucoup plus rapide.

D'autre part, ils permettent à des profanes de devenir eux-mêmes évaluateurs.

En somme, l'impact factor rend possible une évaluation de l'extérieur du milieu scientifique, signifiant pour les détracteurs de l'impact factor une perte d'indépendance et une domination par des profanes.

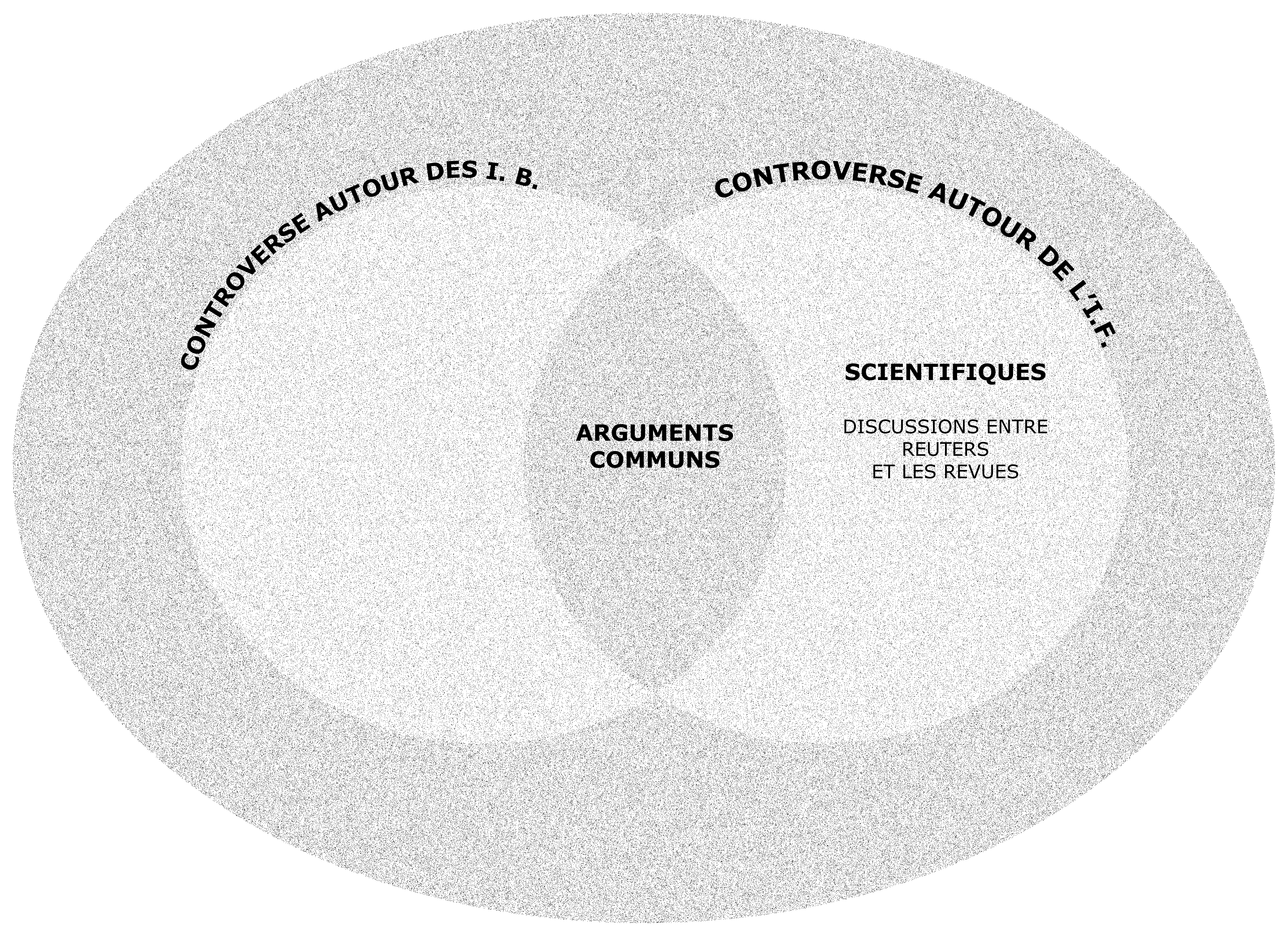

UN EXEMPLE DE SOUS-CONTROVERSE

Lors de notre étude de la controverse autour de l'utilisation de l'impact factor, nous avons été amené à constater qu'il existait plusieurs sous-controverse. C'est-à-dire qu'au sein même de la controverse, il existe des points particuliers d'affrontement et de débats entre les différents acteurs de la controverse. Nous avons donc décidé de vous présenter ici un exemple de sous-controverse. La présentation de cet exemple, nous permet de saisir les mécanismes de diffusion, de développement et d'évolution d'une controverse.

Cette controverse concerne des possibles discussion pré-référencement entre les revues et Reuters pour déterminer les articles qui pouvaient être utilisés pour le référencement de l'impact factor.

Cette sous-controverse débuta en 2007 avec la publication dans The journal of cell biology (lien vers l'article du Journal of cell biology) d'un article critiquant l'opacité du calcule de l'impact factor et une possible négociation entre les Reuters et les revues avant le référencement de l'impact factor.

Cet article fut repris sur un blog suédois assez proche du mouvement défendant la lise à disposition gratuite et en ligne des travaux de recherche. Celui-ci exprima les différentes que l'on pouvait faire de ces négociations.

Ensuite cet article parvint via les commentaires jusqu'au blog d'Antoine Blanchard. ( lien vers http://www.enroweb.com/blogsciences/index.php?2007/12/21/245-facteur-d-impact-des-donnees-en-question#c10803 )

Antoine Blanchard se fit le porte-parole et le relayeur des actualités correspondant à cette controverse. Son blog devint alors l'un des lieux les plus actifs en France pour la controverse autour de l'impact factor.

Il relaya également la réponse de Reuters aux différentes accusation qui lui étaient faites :

Les réponses de Thomson d'ailleurs, bien que typique d'une sous-estimations du rôle des l'impact factor dans le comportements scientifiques, réussi à convaincre plusieurs de ces détracteurs du départ. (lien vers http://www.enroweb.com/blogsciences/index.php?2008/01/11/251-facteur-d-impact-et-thomson-scientific-suite-de-l-affaire) .

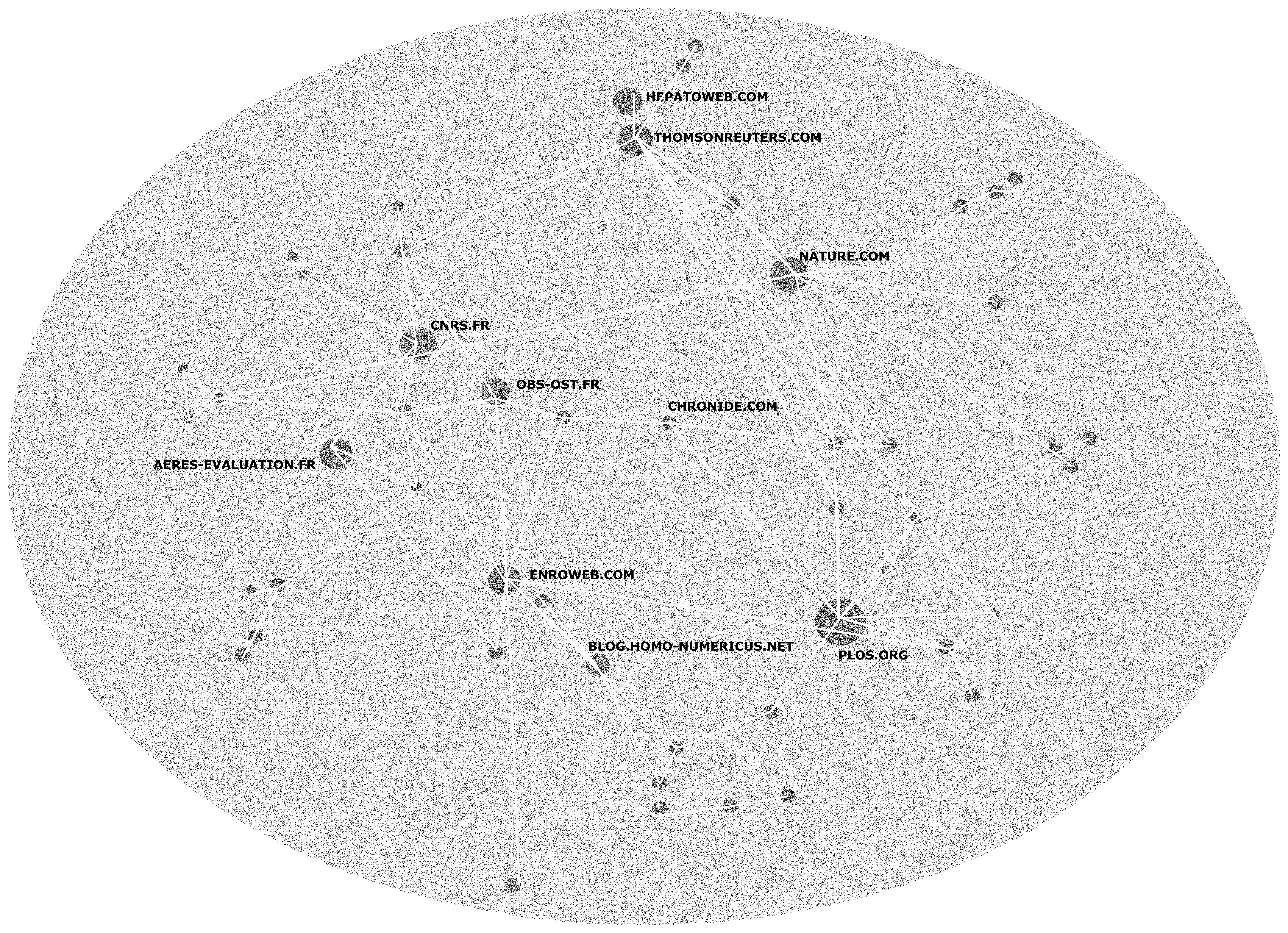

CARTOGRAPHIE DU WEB

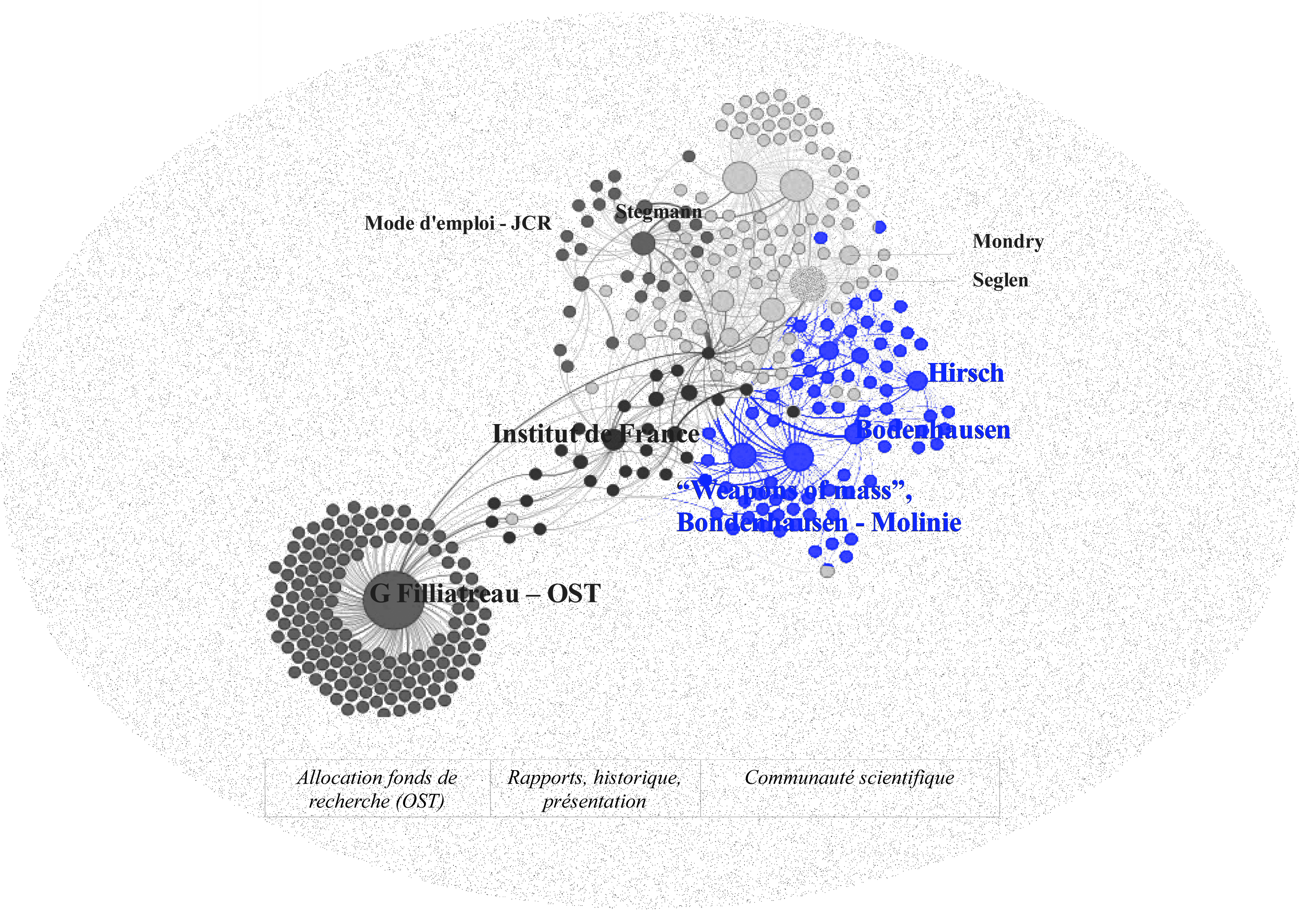

Nous avons été amené à réaliser une analyse-réseau des sites relayant la controverse autour de l'utilisation de l'impact factor.

En quoi une analyse des liens qui peuvent liés les différentes relatant la controverse autour de l'utilisation de l'impact factor peut nous apporter une intelligence plus grande de celle-ci ?

Après avoir fait des remarques générales sur la démarche, je détaillerai les différentes conclusions apportées par notre analyse réseau.

Premièrement, le principal problème que nous avons rencontré est, comme dit ci-dessus, la relative rareté des pages web relatant de la controverse autour de l'impact factor. Cela indique que le web n'est pas vraisemblablement pas l'arène où la polémique est la plus vive et présente. En effet, la plupart des pages web sont en réalité des documents .pdf (35% des 10 premières pages de google sont un document .pdf où donne sur un site présentant un article scientifique .pdf), donc non analysés par notre outil le navicrawler, d'articles scientifiques. Il est donc plausible que la controverse se noue plus particulièrement via les publications scientifiques plus que par internet.

Ceci corrobore notre deuxième observation : la controverse semble assez peu ouverte et quasi-exclusivement le fait d'acteurs scientifiques. Cette assertion est confirmée par la faible présence de la controverse sur internet et la sureprésentation des articles scientifiques dans celle-ci. La plupart des sites ne font qu'expliquer le mode de calcul de l'impact factor. Il existe même des sites réservés aux chercheurs sur lesquels on peut apprendre les techniques pour « pimper » son impact factor. De plus, la quasitotalité des blogs relayant la controverse sont tenus par des chercheurs. Enfin, les seuls journalistiques à relayer la controverses sont ceux de journaux (Chronicle) ou revues (Nature) scientifiques. La controverse est donc avant tout située dans le monde de la recherche.

Enfin, troisièmement, la controverse autour de l'impact factor est mêlée à une controverse plus large qui est celle entourant l'usage des indicateurs bibliométriques dans la scientométrie, c'est-à-dire dans l'analyse et l'évaluation de la recherche. En effet, pour trouver les sites concernant spécifiquement la controverse entourant l'utilisation de l'impact fcator, il a fallu que je passe par le terme « indicateurs bibliométriques ». Néanmoins, certains sites (enroweb.com) se font le relais d'une controverse spécifique de l'impact factor, sur les possibles négociations, préalables au référencement des articles, entre les revues et Reuters (éditeurs du classement via l'impact factor), pour décider des articles « citables ». Il existe donc une controverse propre à l'impact factor bien qu'un des points chauds de la controverse soit commun avec celui d'une controverse plus générale, qui est celle entourant l'usage des indicateurs bibliométriques dans la « scientométrie ».

Avec les sites que j'ai pu néanmoins recueillir, j'ai pu réaliser une première cartographie :

+

La grosseur des nœuds, comme la taille de la police correspond au degré (entrants + sortant) du site. On peut d'ores et déjà remarquer une distinction nette entre deux amas, l'un à droite et haut l'autre en bas à gauche. (Nous verrons plus à quoi correspond ces nœuds).

Langue des sites

La première typologie que nous avons faite est celle de la langue du site. En effet, l'une des critiques faites à l'impact factor est quelle favoriserait les publications en langue anglaise.

+ Représentation des différentes langues

On voit clairement la distinction nette qui existe entre les sites anglophones (très majoritairement américain) et les autres sites. Bien entendu, les sites français sont ici sur représentés (en raison des limites linguistiques de l'utilisateur du navicrawler).

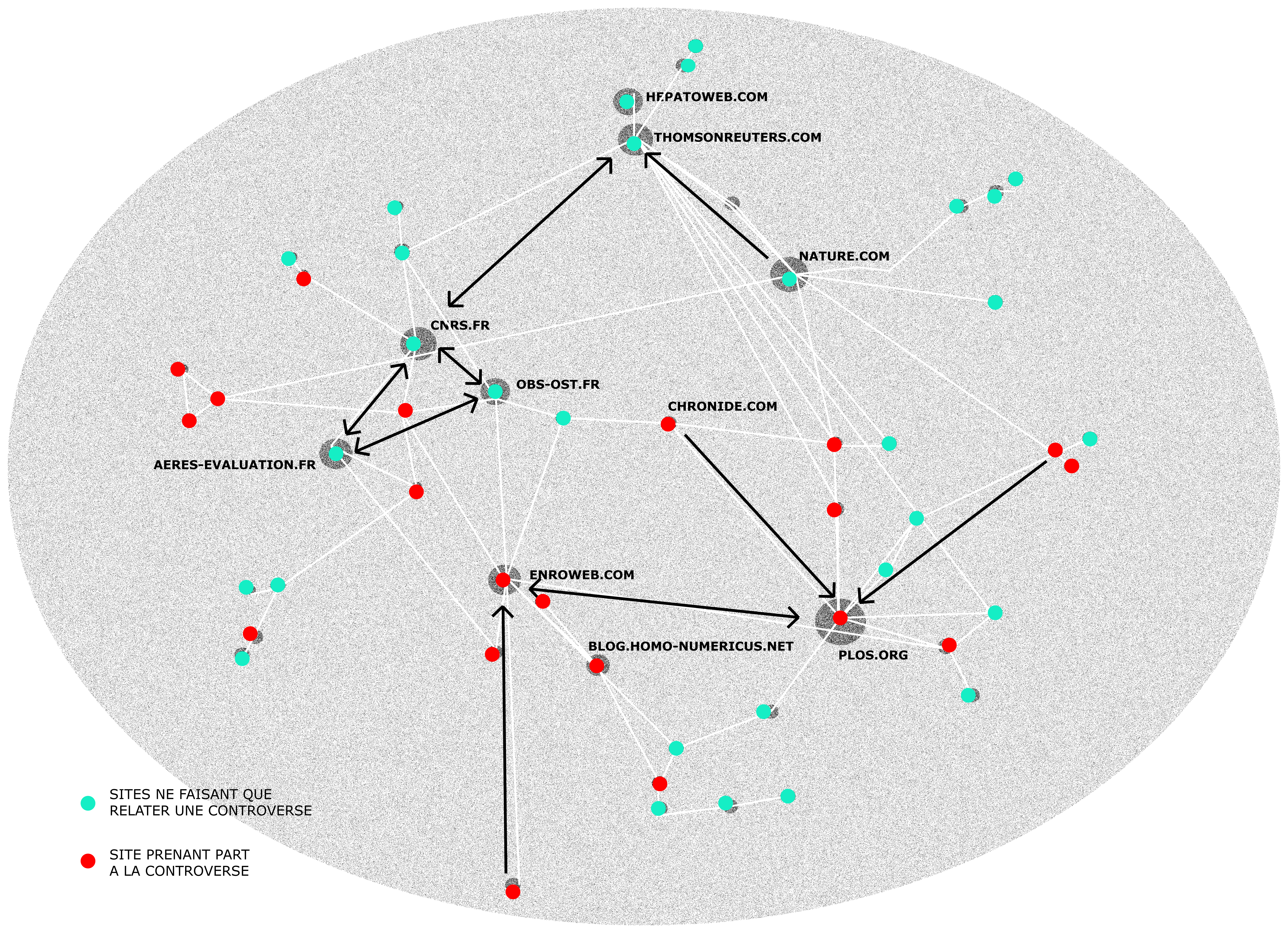

+ Type des sites

On voit bien que les sites institutionnels (entreprise et université) sont majoritaires et assez proches les uns des autres. Ce qui montre bien qu'il existe une sorte de cercle institutionnel : les institutions se font référence entre elles.

À cela s'oppose un autre groupe, celui des blogs. En effet, on voit que les blogs en rouge sont souvent par petits groupes. Il s'agit en effet d'internautes (la plupart du temps des chercheurs) qui parlent de l'impact factor et se renvoient à leurs sites respectifs et commentent les billets des autres bloggers. On voit notamment que le blog Enroweb tenu par Antoine Blanchard (Agronome, Bibliomètre et sociologue des sciences) a joué un rôle important dans le relais en France d'une controverse apparu entre chercheurs anglo-saxons sur une possible négociation pré-parution et référencement entre les revues et Reuters. Ces blogs pointent vers les sites institutionnels mais ce n'est pas réciproque.

Enfin, on voit que les « webzines » ou les sites de revues et autres journaux en ligne font office d'intermédiaires entre les deux groupes précédemment présentés. Ils se réfèrent aux sites institutionnels mais n'hésitent pas à relayer aussi les articles provenant de la nébuleuse « blogosphère ».

Contenu du site

Distinction entre les sites qui ne font que parler d'une controverse sans y prendre part et ceux qui y prennent activement part.

+

ou

+

On voit que les liens entre les sites qui ne font que relater une certaine controverse (le site Thomsonreuters ne fait du tout état d'une controverse sur l'utilisation de l'impact factor) autour de l'impact factor sans vouloir y prendre part sont assez liens entre eux.

Idem de manière opposée pour les sites relayant la controverse et prenant part à celle-ci.

On voit que chacun des deux camps concentre ses liens sur un petit nombre de sites qui se font le relais et l'écho de la controverse ou d'une définition de l'impact factor.

Enfin, il est intéressant de voir que Nature (la revue ayant l'impact factor le plus élevé) se place du côté des tenants de la définition du facteur d'impact sans faire état d'une controverse. A l'inverse, Plos, revue en ligne gratuit et explicitement contre tout forme de classement de revue prend elle aussi une part important dans le débat autour de l'impact factor.

Conclusion

On constate clairement qu'à l'exception notable de la revue Nature, les sites ne prenant pas part à la controverse sont les sites institutionnels. À l'inverse, ce sont les blogs qui relaient la controverse et la polémique autour de l'impact factor. Pour ce qui est des revues, on voit clairement la distinction entre Nature qui ne fait que présenter l'impact factor et son calcul et Plos, qui est un journal prônant la publicité des articles scientifiques et se posant clairement en opposant du système de revue classée par l'impact factor.

VUE D'ENSEMBLE À PARTIR DU TEXT MINING ANALYSE DE CONTENUS DE TEXTES À PARTIR DE LA STATISTIQUE

Hypothèses testées dans cet atelier

Nous tenterons de tester deux hypothèses à partir des techniques de text mining. La première est que ces deux camps d'argumentation antagonistes se distinguent clairement dans la controverse, à partir de registres d'argumentation différents. Le premier, plutôt pour l'impact factor, argue du fait qu'il s'agit d'une mesure mathématique, donc objective, et que sa simplicité de calcul permet par les statistiques une évaluation qualitative des chercheurs, voire de la recherche. Le second, plutôt contre, dénonce le raisonnement simpliste consistant à associer quantité à qualité. Un indicateur de publication ne peut mesurer l'ensemble du travail d'un chercheur.

La deuxième hypothèse est que le groupe des chercheurs regroupe des positionnements complexes et non homogènes dans la controverse. Certains ont une attitude positive vis à vis de l'impact factor.Certains en profitent pour leur propre carrière. D'autres ont des attitudes complètement opposées. Enfin, certains rappellent que l'indicateur en soi n'est pas néfaste, c'est sa pratique qui l'est.

Méthode

Nous allons utiliser le logiciel ANTA développé par le médialab ( HYPERLINK "http://jiminy.medialab.sciences-po.fr/anta_dev"http://jiminy.medialab.sciences-po.fr/anta_dev) et Gephi pour le traitement sous forme graphique.

La première étape consiste au recueil des textes concernant la controverse. L'interview de Ghislaine Filliatreau, directrice de l'Observatoire des Sciences et Techniques, représente le groupe des évaluateurs. Le rapport de l'Institut de France (Académie des Sciences) Du bon usage de la bibliométrie pour l'évaluation individuelle des chercheurs du 17 janvier 2011 représente l'avis des scientifiques "sages", presque "insitutionnalisés". Du côté de Reuters, qui possède et édite aujourd'hui l'impact factor des chercheurs, les articles du créateur Eugène Garfield donnent la tonalité des défenseurs de l'impact factor. D'autres articles publiés par des chercheurs (tribunes) appuient ce camp. Ensuite, l'interview et les textes de Godeffroy Bodenhausen montrent l'opposition scientifique, avec Richard Ernst, Hirsch, Olivier Gandrillon (Sauvons la Recherche) et d'autres. Enfin, certains articles purement scientifiques publiés par des scientifiques s'intéressent à la validité de cette mesure.

La deuxième étape, celle des occurences relevées par Anta nous en a fait retenir 341 sur 9148 au total. Une première élimination a été faite en supprimant celles qui n'étaient contenues dans suffisamment de documents (2). La deuxième élimination s'est faite manuellement, en considérant les entités restantes et en éliminant celles ne présentant pas d'intérêt dans la controverse (géographie, disciplines, nom des revues...), mais aussi en "sauvant" quelques occurences dans celles exclues, qui au contraire apparaissaient intéressantes. Les termes français et anglais correspondant ont été liés.

La troisième étape s'est faite sous Gephi, à partir du graphe. Nous avons lancé l'algorithme de traitement et utilisé l'algorithme de "modularité" afin d'avoir les différentes communauté identifiées par le logiciel. Il en a trouvé cinq. C'est à partir de ce travail que nous présentons nos résultats.

Résultats

Première hypothèse

De manière remarquable, le graphe montre une séparation entre le texte de Ghislaine Filliatreau et les autres, ce qui montre des occurences de termes différents pour l'argumentation de l'OST sur l'impact factor (il s'agit d'une interview).

Les autres textes semblent à première vue beaucoup plus liés, sans considérer les communautés. Cependant, une sorte de zone "tampon" peut être identifiée entre les deux parties avec le raport de l'institut de France, un historique du facteur d'impact, l'entretien avec Audrey Baneyx, voire même le texte du "mode d'emploi" de l'impact factor créé par Thompson Reuters. Cette zone tampon présente des termes de fait assez consensuels et à faible tonalité argumentatives, comme "discipline", "recherche scientifique", "citation rate" (avec lesquels tous les textes ont un lien).

Il s'agit donc de voir de quelle manière les termes de l'OST diffèrent des autres textes. Parmi ceux de l'OST, on retrouve notamment "matériau riche", "indicateurs quantitatif", "interprétation humaine", "usage administratif", "riche d'information", "principe d'un concours", "validité d'hypothèses formulées", "évaluation bienveillante", "hypothèses validées". Ces termes nous confortent dans notre première hyptohèse à savoir que l'argumentation favorable à l'impact factor insiste sur la validité de l'impact factor, indicateur porteur d'information, pouvant servir à l'allocation des fonds de recherche, même s'il est complété par l'interprétation humaine.

Il semble difficile de pouvoir vérifier la validité de l'hypothèse d'argumentation pour l'autre groupe, étant donné la grappe parmi les autres textes, mêlant de fait chercheurs pour et chercheurs contre. Cela nous amène à la deuxième hypothèse.

Deuxième hypothèse

A première vue donc, le camp des chercheurs scientifiques, aussi bien dans leur prise de position que dans leurs travaux scientifiques est complètement mélangé, formant une grappe. Cependant, l'outil des communautés nous aide à y voir plus clair. Trois communautés se distinguent parmi les scientifiques.

Le groupe vert est celui des prises de positionnements des scientifiques contre, avec "rough approximation", "unquenchable thirst", "surreprésentation anglo-saxonne", "false promises" qui formulent des axes de critiques (se rapprochant du deuxième camp d'argumentation, dans la première hypothèse). Le groupe rouge est assez peu concluant dans la nature de son argumentation, il présente beaucoup de similitudes avec le groupe tampon, il s'agit en réalité du mode d'emploi, et de textes présentant des méthodes d'évaluation de l'impact factor (sans conclure). Quant au groupe bleu ciel, il est clairement diversifié, avec des termes comme "subjective evaluation", mais aussi "quantitative measure", "quality assessment tool". De fait il regroupe des chercheurs pour (notamment le créateur Eugène Garfield), des évaluations scientifiques et des chercheurs contre.

Enfin, l'outil degré entrant montre chez les chercheurs qu'au-delà de "citation rate" et "impact factor" dont c'est le sujet ici, les termes "prix nobel" et "google" font partie des plus utilisées, montrant que la qualité scientifique ne se mesure pas seulement à des indicateurs bibliométriques.

Conclusion et critique

Si le premier camp d'argumentation a pu être identifié et associé au au financeur qu'est l'OST, le deuxième camp n'a pas pu être clairement visualisé, même s'il s'identifie plutôt au groupe vert des sientifiques, ce qui ne valide que partiellement la première hypothèse. Cependant la deuxième hypothèse nous semble vérifiée, avec le groupe bleu ciel des scientifiques qui regroupe des chercheurs ayant des positions différentes. La présence de davantage de textes de chaque groupe de la controverse aurait sans doute pu faire émerger plus d'occurences liées directement aux argumentations, permettant de valider entièrement notre première hypothèse. La validation de la seconde hypothèse implique donc un travail de modélisation plus avancé (méritant ensuite d'être testé empiriquement), permettant une meilleure différenciation des acteurs du groupe des chercheurs.

EPILOGUE

Finalement, notre étude nous a permis de mieux comprendre la communauté scientifique et ses ressorts. Le facteur d'impact révèle en effet bien des enjeux au niveau microsociologique, c'est-à-dire au niveau des relations entre chercheurs. La concurrence, pour commencer, qui peut exister entre chercheurs, et surtout entre laboratoires. La réputation également qui, même si son influence a toujours été présente, a pris une importance considérable dans la marche du monde scientifique. La publication scientifique enfin qui, à l'heure de la globalisation et de la démocratisation de l'enseignement supérieur, semble plus que jamais le nœud de toute activité de recherche.

Etudier la controverse autour du facteur d'impact, c'est pénétrer dans les coulisses du monde de la recherche ; c'est entrer au cœur de cette boîte noire qu'est la sphère scientifique, dont on ne voit habituellement que la partie émergée : les résultats. La cartographier, c'est avant tout comprendre que le chercheur n'est pas – ou plus – l'alpha et l'oméga de la production de connaissance. De multiples acteurs viennent se greffer tout au long du processus. Qu'il s'agisse des financeurs en amont de la recherche, ou des éditeurs en aval, tous apposent leur marque, leurs intérêts, leur philosophie à la production scientifique. Finalement, le débat sur le facteur d'impact est un débat sur la place que doit avoir chacun dans la chaîne. La controverse sur le facteur d'impact met donc fin à une utopie : celle du laboratoire clos et hermétique au monde extérieur. Désormais, le social et le scientifique doivent être étudiés et compris en parallèle, tant l'étude de l'un sans l'autre comporte d'impasses et de contre-sens. A ce titre, elle est tout à fait représentative de la philosophie du cours de cartographie des controverses dans lequel s'inscrit notre étude.

Cette controverse est d'ailleurs récemment revenue sur le devant de la scène avec la parution en février 2012 d'un numéro de la revue Quaderni intitulé « L'évaluation de la recherche: pour une réouverture des controverse ». Se livrant à un véritable exercice de cartographie, la revue s'intéresse plus largement aux questionnements sur l'évaluation de la recherche, dont la controverse sur le facteur d'impact fait partie intégrante. Plus que jamais donc, l'indicateur fait débat, et nous espérons que notre site apportera à ceux qui souhaitent approfondir la question des éléments pour nourrir leur réflexion.

Pour finir, nous tenions à remercier Mme G. Filliatreau, M. G. Bodenhausen, Mme A. Baneyx, M. O. Gandrillon, M. A Polian et Mme S. Saha pour leur aimable contribution à notre enquête. Leurs points de vue, leurs analyses et leurs expériences nous ont été d'une aide précieuse pour la réalisation des contenus de ce site. Un grand merci également à toute l'équipe pédagogique du cours de cartographie des controverses sans qui ce projet n'aurait pu voir le jour, et plus particulièrement à M. T. Venturini et M. J-N. Jouzel, pour leur investissement et leurs conseils.

RANGER

SOMMAIRE

PRÉSENTATION ET CONTEXTE

QU'EST-CE QUE LE FACTEUR D'IMPACT ?

- • La genèse du facteur d'impact

- • Historique : le facteur d'impact des années 1950 à aujourd'hui

- • Le facteur d'impact à travers le monde

- • Notre enquête

- • L'instrument des maisons d'édition

- • Indicateur ou statistique ?

- • Cercle vertueux versus cercle vicieux

- • Le chiffre et la décision

- • Les critiques méthodologiques

- • L'inertie historique

- • Science et société

- • Le rôle de l'argent

- • Une question de valeurs

- Une controverse connexe

- • Le facteur d'impact sur le Web

- • Les acteurs de la controverse

- • Les apports du Text-Mining

- • Epilogue

Un constat partagé : l'histoire d'un détournement

Le camp de la réforme

Le camp de la révolution

Vue d'ensemble

GLOSSAIRE

A

Article de revue scientifique

Il s'agit d'un article dans lequel un chercheur décrit ses recherches ainsi que ses résultats. La rédaction peut être théorique ou technique mais peut aussi viser à vulgariser les données. L'article est soumis à l'examen d'un comité de lecture de la revue avant publication.

Auto-citation

Il s'agit du nombre de citations dans un journal donné de travaux publiés dans ce même journal. Pour un chercheur, il s'agit du nombre de citations d'un auteur à ses propres travaux.

AERES

(Agence d'Évaluation de la Recherche et de l'Enseignement)

Autorité administrative indépendante française chargée de l'évaluation de la recherche scientifique. Créée en 2006, cette agence est composée de comités d'évaluation qui se rendent dans les laboratoires scientifiques. Les critères utilisés par l'AERES pour ses évaluations sont notamment les indicateurs bibliométriques et donc l'mpact factor

ANR

(Agence Nationale de la Recherche)

Etablissement public à caractère administratif, l'ANR a été créé en 2005 afin de financer les équipes de recherche, par l'utilisation de contrats à durée déterminée (financement par projet). Elle a été mise en place dans un contexte de restrictions budgétaires.

B

Base de données

Il s'agit d'une collection de données visant à faciliter le traitement et la recherche d'information. Dans le cadre de notre controverse, nous abordons essentiellement les bases de données bibliométriques, à partir desquelles sont élaborés les indicateurs. (C'est-à-dire principalement celles proposées par l'entreprise Reuters).

Bibliométrie

Définie par Pritchard comme « l'application des mathématiques et des méthodes statistiques aux livres, articles et autres moyens de communication », la bibliométrie consiste en la fabrication d'indicateurs dont le but est de refléter les qualités de parutions en particulier scientifiques.

Bibliologie

La bibliologie est l'ensemble des sciences du livre, en particulier son histoire, sa fabrication, ou encore sa diffusion.

C

Chercheurs

« Spécialistes travaillant à la conception ou à la création de connaissances, de produits, de procédés, de méthodes et de systèmes nouveaux et à la gestion des projets concernés » (OCDE, Manuel de Frascati, 2002).

Citation

Mention dans un article à des travaux réalisés par la communauté scientifique sur un sujet donné. Le terme citation indique l'action de citer une référence. Elle fait l'objet d'une véritable formalisation. Une citation peut être positive (indiquer la qualité du travail) ou négative (les auteurs ne font référence à l'article que pour souligner son manque de pertinence).

CNRS (Centre national de la recherche scientifique)

« Organisme public de recherche (Etablissement public à caractère scientifique et technologique, placé sous la tutelle du Ministère de l'enseignement supérieur et de la recherche). Il produit du savoir et met ce savoir au service de la société. » (CNRS)

D

Domaine de recherche

Ensemble de travaux portant sur des objets ou des sujets ayant un rapport entre eux.

I

Indicateur

Un indicateur est un chiffre informatif. Contrairement à la statistique, il nécessite une interprétation.

ISI (Institute for Scientific Information)

Cet institut, fondé par Eugène Garfield en 1960 a pour but de fournir aux scientifiques des bases de données bibliographiques. Il est composé de trois bases, suivant les domaines traités:

-Science Citation Index (SCI)

-Social Sciences Citation Index

- Arts and Humanities Citation Index (A & HCI)

O

OST (Observatoire des sciences et techniques)

Agence française productrice d'indicateurs bibliométriques autres que le facteur d'impact, mais dont certains se basent également sur le nombre de citations.

P

Page Rank

Le Page Rank est un outil de classification des pages web, en particulier utilisé par le moteur de recherche Google. Son point commun avec une classification des articles par le facteur d'impact est qu'il repose sur la popularité des pages, évalué de façon quantitative.

R

Référence

Traditionnellement, une référence est présentée dans les notes en bas de page ou dans la bibliographie de fin de document. Il s'agit des documents que l'auteur mentionne comme source d'information.

Revue scientifique

RRevue ayant pour objectif la publication de travaux, examinés auparavant par un comité de lecture. Ces revues sont spécialisées dans un domaine précis : les sciences humaines, la physique...

F

Facteur d'impact

Le facteur d'impact est un indicateur bibliométrique. Il est calculé en utilisant le nombre de citations d'un article scientifique. Son utilisation est généralisée dans le monde de la recherche, en particulier en ce qui concerne l'évaluation. Cependant, l'usage de l'indicateur est particulièrement controversé.

J

JCR

(Journal Citation Report)

Il s'agit du rapport annuel de l'ISI, publiant les indicateurs bibliométriques de cette année précise. Auparavant le seul moyen d'accès des indicateurs, il est aujourd'hui double du Web of Science.

S

Statistique

Contrairement à un indicateur, il s'agit d'une forme de dénombrement dont la validité ne peut être contestée dans la mesure où elle ne laisse aucune place à l'interprétation humaine.

T

Thomson Reuters

Agence de presse canadienne et société d'édition. Nommée ainsi depuis le rachat de la société Reuters en 2007, elle est actuellement propriétaire de l'impact factor.

W

Web of Science

Service d'information mis en place par Thomson Reuters, sous forme de moteur de recherche. Il permet l'accès aux indicateurs bibliométriques ainsi qu'aux classements des revues selon ces indicateurs.

LE FACTEUR D'IMPACT

1.EDITO

2.La genèse du facteur d'impact

3.Historique : le facteur d'impact des années 1950 à aujourd'hui

4.Le facteur d'impact à travers le monde

5.Notre enquête

6.L'instrument des maisons d'édition

7.Indicateur ou statistique ?

8.Cercle vertueux versus cercle vicieux

9.Le chiffre et la décision

10.Les critiques méthodologiques

11.L'inertie historique

12.Science et société

13.Le rôle de l'argent

14.Une question de valeurs

15.Une controverse connexe

16.Le facteur d'impact sur le Web

17.Les apports du Text-Mining

18.Les acteurs de la controverse

19.Epilogue